I. Stable DiffusionにおけるLoRAの導入

A. LoRA(Low-Rank Adaptation)の定義

LoRA(Low-Rank Adaptation)は、大規模な事前学習済みモデルを効率的にファインチューニングするための手法であり、Parameter-Efficient Fine-Tuning(PEFT)の一種として広く認識されています1。この技術の核心は、モデルの元の重み(パラメータ)の大部分を凍結したまま、少数の新しいパラメータ(低ランク行列)のみを導入し、訓練することにあります1。具体的には、ファインチューニング中に学習されるべき重みの更新行列(ΔW)を、二つのより小さな低ランク行列(AとB)の積(ΔW ≈ BA)で近似します1。この行列分解がLoRAの主要な革新点です1。完全なファインチューニング(モデルの全パラメータを更新する手法)と比較して、LoRAは更新するパラメータ数を大幅に削減し、計算効率を著しく向上させます1。

B. Stable DiffusionにおけるLoRAの適用と役割

Stable Diffusionのような拡散モデルにおいて、LoRAは特に、テキストプロンプトと画像表現の関係性を学習するクロスアテンション層(UNet内)や、場合によってはテキストエンコーダーに適用されることが一般的です4。その主な目的は、比較的小規模な画像データセットを用いて、Stable Diffusionの基盤モデル(例:SD 1.5、SDXL)を特定の新しい概念、スタイル、あるいはキャラクターに適応させることです3。これにより、「アニメ風」「リアル風」といった画風の調整18や、特定のキャラクター10、スタイル19、コンセプト20を学習したLoRAモデルを作成できます。生成されるLoRAファイルは、基盤となるチェックポイントモデルに対する「学習された差分」または適応情報を記録したものです21。

C. LoRA利用の主な利点

LoRAの採用には、以下のような顕著な利点があります。

- 効率性: 完全なファインチューニングと比較して、訓練時間が大幅に短縮されます1。

- 計算要件の低減: 必要なGPU VRAMが少なく、コンシューマー向けのハードウェアでもファインチューニングが可能になります1。例えば、11GB程度のVRAMでも実行可能です4。

- モデルサイズの縮小: LoRAファイルは数MBから数百MB程度と、数GBに及ぶ完全なモデルチェックポイントと比較して非常に小さく、保存や共有が容易です1。ファイルサイズは適用されるランクや層に依存します22。

- 移植性と合成可能性: 単一の基盤モデル上に複数の軽量なLoRAを構築でき、推論時にこれらを組み合わせて適用することも可能です6。

- 同等の品質: 適切な設定を行えば、完全なファインチューニングに匹敵する品質を達成できるとされています1。ただし、特定のドメイン(例:コーディング)では性能差が見られるという研究もあります11。

- 推論レイテンシなし(マージ時): LoRAの重みは基盤モデルの重みにマージ(統合)できるため、マージ後は推論時の追加計算コストが発生しません6。

D. 本セクションの含意

LoRA技術は、大規模拡散モデルのファインチューニングに必要な計算資源と専門知識のハードルを劇的に下げることで、モデルのカスタマイズを民主化しました。完全なファインチューニングが要求する大量のVRAM15や生成される巨大なファイルサイズ3に対し、LoRAは少ないVRAM4、高速な訓練3、そして極めて小さな出力ファイル3を実現します。これにより、個人や小規模チームでもStable Diffusionのような強力な基盤モデルを特定の目的(キャラクター、スタイルなど)に適応させることが可能となり、多様なクリエイターコミュニティと特化モデルの発展を促進しています12。

LoRAの根幹をなす低ランク分解の原理は、ファインチューニングによるモデル更新ΔWが本質的に低次元の部分空間に存在するという仮説に基づいています1。LoRAがΔWをABで近似する1のは、このΔWが低い「固有ランク(intrinsic rank)」を持つ場合に特に有効です1。しかしながら、完全なファインチューニングによる更新が高ランクである可能性も研究で示唆されており11、これがLoRAが一部の複雑なタスクで完全ファインチューニングに劣る場合がある11理由や、慎重なハイパーパラメータ調整を要する理由を説明するかもしれません。これは、効率性と適応の完全な表現能力との間の根本的なトレードオフを示唆しています。

II. LoRAにおけるNetwork Alphaの理解

A. 定義と主要な目的

Network Alpha(PEFTやDiffusersの設定では lora_alpha として参照される6)は、LoRAの訓練および推論時に使用されるスカラー型のハイパーパラメータです5。その主な役割は、学習されたLoRAの更新行列(AおよびB)に対するスケーリング係数として機能することです5。

B. LoRA方程式におけるスケーリング係数としての機能

LoRAで適応された層の順伝播(フォワードパス)は、一般的に次のように表されます: h = W0*x + (alpha / r) * B*A*x 5。

- W0: 凍結された元の重み行列。

- x: 入力。

- A, B: 学習された低ランク行列(ΔW ≈ BA)。

- r: 行列AおよびBのネットワークランク(次元)。

- alpha: Network Alphaパラメータ。

- (alpha / r): LoRAの更新に適用される重要なスケーリング係数5。

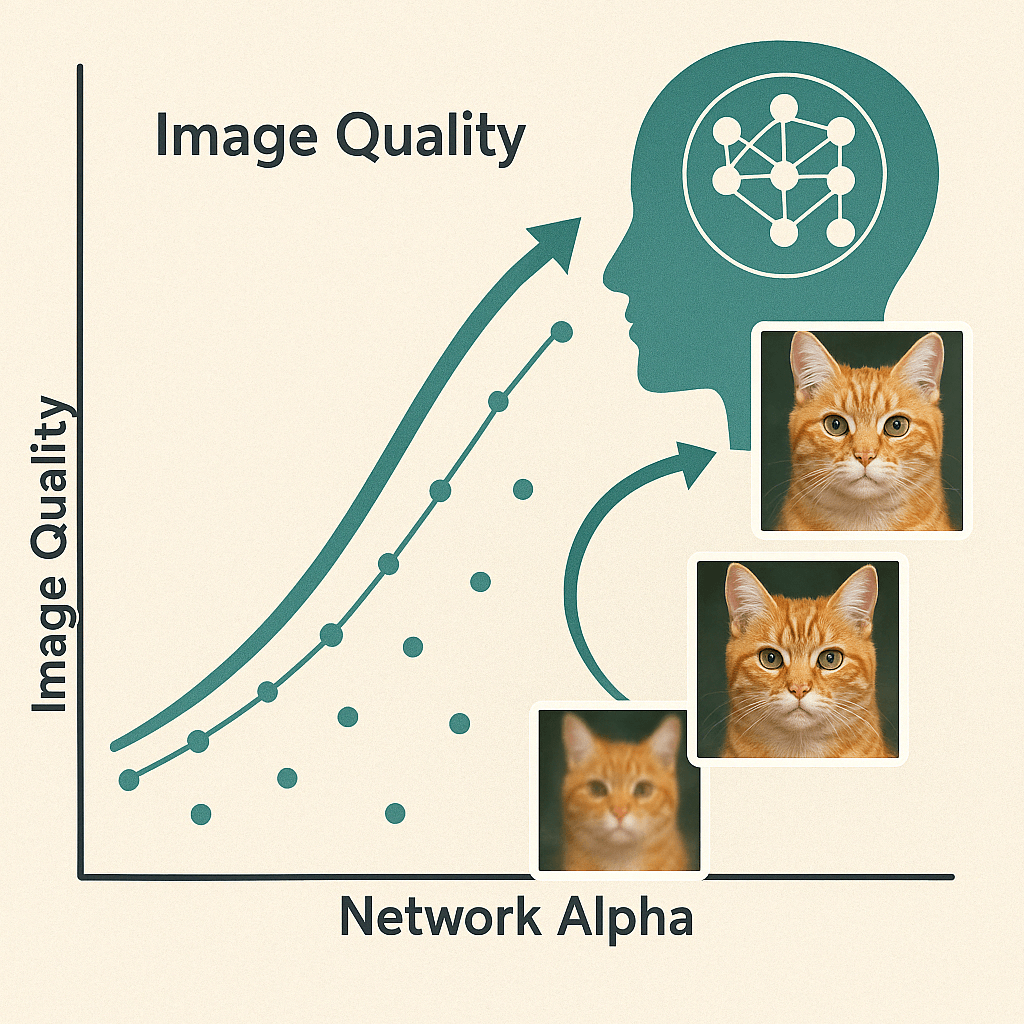

このスケーリング係数 (alpha / r) は、基盤モデルの出力に加えられるLoRA適応の強度または大きさを直接制御します5。r に対して alpha が大きいほど、LoRAの影響力が増加します27。視覚的な表現では、alphaはLoRA更新の「強度」や「重み」を制御するものとして描かれることがあります31。

C. 重み保存/ゼロ化防止における潜在的役割

一部の情報源では、alphaはLoRAの重みが保存時に極端に小さい値になった場合にゼロに丸められるのを防ぎ、学習された情報を保持するために設計されたと示唆されています28。これは、重みを保存時には大きな値として保持しつつ、訓練時には(alpha/rでスケールされて)より小さく見えるようにするメカニズムを導入すると説明されています28。

関連するコミュニティの解釈として、alphaをランクより低い値(例:alpha = rank / N, N > 1)に設定することで、訓練中に重みがゼロになる確率を減らし、活性化状態を保つという説があります38。しかし、38が示すように、この特定の理由付けは提供された情報源の中では広く文書化されているか、確認されているわけではないようです。

別の解釈として、alpha/r スケーリングは、r(ランク)を変更した際の訓練の安定性を助け、学習率のような他のハイパーパラメータを再調整する必要性を減らすことを目的としているというものがあります5。

D. 本セクションの含意

Network Alphaは独立したパラメータではなく、主にネットワークランク(r)との比率(alpha/r)を通じて機能します。この比率を理解することが、その効果を解釈する鍵となります。LoRAの方程式 h = W0*x + (alpha / r) * B*A*x は、alphaの効果がランクによって媒介されることを明確に示しており5、議論もしばしばこの比率を中心に展開されます32。alphaまたはランクを独立して変更するとこの比率が変わり、結果としてLoRA適応の実効的な強度が変化します。これは、「alphaをXに設定する」といった推奨が、ランクを指定しなければ不完全であることを意味します。

Alphaが重みのゼロ化を防ぐという提案されたメカニズム28は、訓練の安定性や適応強度に対するスケーリング係数としての役割5と比較して、公式なドキュメント(PEFTの6など)ではあまり強調されていないようです。これは、コミュニティのヒューリスティックであるか、あるいは主要な設計目標ではなく二次的な効果である可能性があります。公式な情報源5は一貫して、順伝播における alpha/r スケーリングと学習率/安定性との関連を通じてalphaを定義しています。「ゼロ化防止」の考え28は特定のガイドやフォーラムで見られますが、全体として同じレベルの一貫した説明が欠けています。スケーリングが間接的に、より高い名目上の学習率を許容することで小さな更新の保持を助ける可能性はありますが、28で説明されている直接的なメカニズム(より大きな値を保存する)は、LoRAのコア論文やライブラリからのさらなる裏付けが必要です。

Alphaの役割の解釈は、使用する訓練フレームワークやライブラリ(例:kohya_ss対PEFT/Diffusers)によって異なる可能性があります。Diffusersのドキュメント16では、「安定した学習とアンダーフロー防止のため」の network_alphas に言及し、kohya-ssスクリプトの文脈にリンクしています。PEFTのドキュメント6は、適応強度と安定性のための alpha/r または alpha/sqrt(r) スケーリング係数により焦点を当てています。根底にある数学(alpha/r スケーリング36)は類似しているかもしれませんが、強調点や用語が異なることが、コミュニティの混乱の一因となっている可能性があります。

III. Network AlphaとNetwork Rank(次元)の相互作用

A. Network Rank(r または Dim)の定義

ランク(Rank)は、LoRAアダプタを構成する低ランク行列A(形状 d_in x r)とB(形状 r x d_out)の内側の次元を決定します1。これは、LoRAアダプタ内の訓練可能なパラメータの数を直接決定します1。ランクが高いほど、パラメータ数は多くなります5。ランクはLoRAモデルの「表現能力」または容量(capacity)を制御します28。ランクが高いほど、より細かいディテールや複雑な適応を捉える能力が高まります1。

B. Alpha/Rank スケーリングメカニズム (alpha/r)

既に確立されているように、標準的なLoRA実装では、更新 BAx を alpha/r でスケーリングします5。このスケーリングは、ランクに対して適応の大きさを正規化し、ランクが変更された場合でもより安定した訓練を目指すことを意図しています5。考え方としては、ランクが大きい行列は自然により大きな出力を生成する可能性があるため、r で割ることでこれを補正します5。

C. Rank-Stabilized LoRA (rsLoRA) (alpha/sqrt(r))

研究(5で引用されているrsLoRA論文)により、alpha/r スケーリングは過度に積極的であり、特にランクが増加するにつれて不安定性を引き起こしたり、効果が減少したりする可能性があることが判明しました5。rsLoRAは、代わりに alpha / sqrt(r) をスケーリング係数として使用することを提案しています5。このより穏やかなスケーリングは、訓練を安定させ、より高いランクの潜在能力をより良く活用できると主張されています5。PEFTライブラリでは、use_rslora=True を設定することでこれを有効にできます6。一部の議論では、rsLoRAでは alpha=1 が最適であり、実質的にスケーリングを 1/sqrt(r) にすることが示唆されています42。

D. ランクの影響:ディテール対過学習のトレードオフ

- 高ランク: 細かいディテール、複雑なスタイル、特定のキャラクターの類似性を学習する能力が高まります1。しかし、訓練データへの過学習のリスクを高め、柔軟性や汎化能力を低下させる可能性があります22。より多くのVRAMを必要とし、より大きなLoRAファイルが生成されます5。より多くのデータや低い学習率が必要になる場合があります43。

- 低ランク: モデルが単純になり、過学習しにくく、より汎化しやすい可能性があります28。ファイルサイズが小さく、訓練が速く、VRAM使用量も少なくなります20。しかし、複雑なタスクや細かいディテールのキャプチャには不十分である可能性があり28、学習不足(underfitting)につながることもあります17。

- 最適なランクは、タスクの複雑さ(例:スタイル対キャラクター対コンセプト)およびデータセットのサイズ/多様性に依存します28。

E. 本セクションの含意

ランクの選択はLoRAの学習能力を根本的に定義し、一方でalphaはその能力が基盤モデルに対してどれだけ強く表現されるかを調整します。これらはスケーリング係数を介して本質的に結びついています。ランクは更新行列AとBの次元(r)を設定し1、alphaは alpha/r または alpha/sqrt(r) の比率を通じて、順伝播で適用される更新 BAx の実効的な大きさを決定します5。したがって、ランクは何を学習できるか(複雑さ)を決定し、alpha/rank比率は学習された適応がどれだけ影響力を持つかを決定します。高いランクと非常に低いalpha/rank比率の組み合わせは、複雑なディテールを学習しても弱く適用する可能性があり、逆に低いランクと高いalpha/rank比率の組み合わせは、単純な学習特徴を非常に強く適用する可能性があります。

rsLoRA(alpha/sqrt(r))の存在と採用は、元の alpha/r スケーリングが普遍的に最適ではない可能性、特に高ランクにおいて適応を過度に抑制する可能性があることを示唆しています。rsLoRA論文は、高ランクでの勾配消失など、alpha/r スケーリングの問題点を明確に指摘しています5。rsLoRAが高ランクでより良い性能を引き出すという主張5は、元のスケーリングが制限要因であったことを示唆しています。PEFTでの use_rslora の採用6は、これが認識された改善または代替案であることをさらに裏付けています。これは、「最適な」alpha/rankの関係が、使用されるスケーリング関数(1/r 対 1/sqrt(r))に依存する可能性があることを示唆しています。

alpha/r スケーリングの理論的な動機(ランク間での訓練安定化5)と、性能が必ずしも期待通りにランクと共にスケールしない、あるいは低ランクでも高いalpha値が低いものを上回るという経験的な発見5との間には、潜在的な乖離が存在します。5/5は、特定のタスクとデータセットにおいて、ランクに関係なく(例:r=2またはr=128)、より高いalpha(例:512)が最良の性能を示し、標準的なLoRAスケーリングではランクを上げても必ずしも性能が大幅に向上しなかった実験を報告しました。これは単純な正規化の目標と矛盾し、alpha、ランク、学習率、そして特定のデータセット/タスク間の相互作用が、スケーリング係数だけが説明するよりも複雑であることを示唆しています。データセットが十分に挑戦的でなかったか、あるいは alpha/r スケーリング下で高ランクに対して学習率が最適でなかった可能性があります(rsLoRAが助けになったように)。

IV. Network AlphaがLoRA訓練プロセスに与える影響

A. 収束と安定性への影響

Alphaは、alpha/r スケーリングを通じて、LoRAパラメータ更新の実効的なステップサイズに影響を与えます。不適切な設定は安定性に影響を及ぼす可能性があります。元の alpha/r スケーリングは、ランクを変更する際に安定性を維持することを目的としていました5。しかし、rsLoRA(alpha/sqrt(r))は、特に高ランクにおいて、より良い安定性をもたらす可能性があるとして提案されています5。極端に高い実効学習率(高い alpha/r または高い基本学習率に影響される)は、不安定性や発散につながる可能性があります5。一部のガイドでは、安定性のためにalphaをランクに比例させることを推奨しています28。

B. 実効学習率(LR)との関係

Adamスタイルのオプティマイザを使用する場合、alphaの調整は、適切な初期化スケーリングを前提とすれば、学習率の調整とほぼ同等であると考えられています5。ランク8において、(alpha=1, LR=0.00512)と(alpha=512, LR=1e-5)で同様の結果が得られた実験があります5。実効学習率は alpha/r によって影響を受けます34。ランクに対してalphaが高いほど、LoRAの重みに対する実効学習率が効果的に増加します34。

一部の情報源では、alphaが学習率の減衰器(dampener)として機能すると述べられており47、低いalphaは(固定された基本LRに対して)学習を遅くするとされています。これは alpha/r スケーリングの直接的な乗法効果とは逆に見えますが、alpha=rankを基準とした場合の解釈かもしれません。Civitai Wiki47は具体的に、alpha=16, rank=32がLRを半減させると述べており、これはalpha < rankがalpha=rankの場合と比較して実効LRを低下させることを意味します。これは解釈の矛盾を浮き彫りにしています。

alpha/r スケーリング係数は、ランクを変更する際にLRを再調整する必要性を減らすことを目的としています5。

C. 訓練強度/適応強度への影響

alpha/r 比率は、訓練中に適用されるLoRA適応の強度を直接制御します28。高い alpha/r はより強力な更新をもたらし、モデルを基盤の重みからファインチューニングデータへとより遠ざけます27。低い alpha/r はより弱い更新をもたらし、モデルを基盤の重みに近づけます29。

D. オプティマイザとの相互作用

AlphaとLRの関係は、特にAdamスタイルのオプティマイザで注目されています2。ProdigyやDAdaptationのような適応型オプティマイザは、LRを自動的に調整する可能性があり、手動でのalpha調整の重要性を低下させたり、異なる相互作用を示したりするかもしれません41。Prodigyはalpha/rank設定に基づいてLRを調整することが観察されています41。異なるオプティマイザは異なる基本学習率を必要とする可能性があり、それが alpha/r スケーリングと相互作用します45。AdafactorはAdamWと並んで言及されています45。

E. 本セクションの含意

Network Alphaは、LoRAパラメータに特化した学習率の重要な調整因子として機能し、オプティマイザで設定された基本学習率と絡み合っています。この相互作用は複雑であり、オプティマイザに依存します。Adamにおけるalpha調整とLR調整の等価性5、および更新に対する直接的なスケーリング効果(alpha/r)34は、alphaがLoRA重みのステップサイズに直接影響を与えることを示しています。しかし、この効果は基本LRの上に起こります。Prodigyのような適応型オプティマイザがalpha/rankの変化に反応する41ことは、この相互作用をさらに裏付けています。Alphaを「減衰させる」47対「スケーリングする」5という矛盾した記述は、おそらく異なる基準仮定(例:alpha=rank対alpha=0との比較)から生じています。

スケーリング関数(alpha/r 対 alpha/sqrt(r))の選択は、特に高ランクにおいて、最適なalpha/LRの組み合わせに影響を与える可能性が高いです。もし alpha/r が高ランクで過度に積極的になるなら5、安定性を維持するためにより低い基本LRまたは低いalphaが必要になるかもしれません。逆に、rsLoRAのより穏やかな alpha/sqrt(r) スケーリングは、高ランクで不安定性を引き起こすことなく、より高い基本LRまたは高いalpha値を許容するかもしれません5。これは、訓練の安定性と収束挙動がこのスケーリング選択に直接結びついていることを示唆しています。

ランク変更時にLRの再調整を不要にするという alpha/r スケーリングの目標5は、実際には部分的にしか成功しない可能性があります。スケーリングがある程度の正規化を提供する一方で、経験的な結果は、性能が必ずしもランクと共に予測通りにスケールするわけではないこと5、そして推奨事項がしばしばランク、alpha、LRの共同調整(または適応型オプティマイザへの依存)を伴うことを示唆しています。データセットの複雑さや特定のタスクのような要因が、単純なスケーリング係数が提供するもの以上の調整を必要とするかもしれません。最初にLRを調整し、次にalphaを変更せずにランクを調整するという推奨ワークフロー5は、この実践的な流れを認めています。

V. Network Alphaが生成画像品質に与える影響

A. 低Alpha値 vs 高Alpha値(ランク比)の一般的影響

- 低Alpha(または低い alpha/r 比率、例:alpha=1, alpha=rank/2):

- 基盤モデルに対するLoRA適応の影響力を増加させます(17の解釈)。学習された概念/スタイル/キャラクターを優先する傾向があります50。

- より強力な学習につながり、特定のディテールや類似性をより良く捉える可能性があります50。

- 過学習のリスクが高まります:モデルが訓練データを「記憶」し、柔軟性を失い、新しいプロンプトに対応できなくなったり、望まないディテールが焼き付いたりする可能性があります17。

- 推論時にLoRAの重み/強度を低く設定する必要があるかもしれません40。

- 極端に低い場合(例:不十分な訓練/ランクでalpha=1)、適切に学習できない可能性があります50。

- 高Alpha(または高い alpha/r 比率、例:alpha=rank, alpha=rank*2):

- 基盤モデルに対するLoRA適応の影響力を減少させます(17の解釈、直接的なスケーリング効果とは逆)。あるいは、直接的なスケーリング(5)に従えば、高いalphaはLoRAの影響力を増加させます。5。

- 高Alpha = 高影響と仮定した場合: 初期学習が速い可能性があります(実効LRが高いため)。一部の実験では良好な性能を示します(5はテストでalpha=512が最良でした)。

- 学習率が調整されない場合、不安定性、アーティファクト、または「焼き付き」画像のリスクが高まります50。LoRAが基盤モデルを「上書き」しすぎ、柔軟性を低下させる可能性があります51。

- Alphaが高く、かつランクも高い場合、深刻なアーティファクトや変形を引き起こす可能性があります50。

B. 特定の画像品質側面への影響

- スタイル忠実度: ランクに対するalphaが低いほど、スタイルをより強力に捉えるかもしれませんが、硬直的になる(過学習)可能性があります。Alphaが高いほど、スタイルが基盤モデルとより微妙にブレンドされ、柔軟性を提供するかもしれませんが、スタイルの忠実度が弱まる可能性があります(29から推測)。ランクもここで主要な役割を果たします(51はスタイルには高ランクを示唆)。

- ディテール再現性: 細かいディテールには一般的に高いランクが必要です28。Alphaの役割は二次的ですが、学習されたディテールがどれだけ強く現れるかに影響します。過学習(低いalpha/高い実効LRによって促進される可能性がある)は、望ましくない「記憶された」ディテールにつながる可能性があります40。

- アーティファクト: 過学習や不安定性と共に発生する可能性があります。実験では、高ランク+高alpha50または高ランク+低alpha50の両方がアーティファクトにつながる可能性が示唆されています。バランスを見つけること(例:50でのrank=86, alpha=86)が鍵でした。

- 過学習: 柔軟性の欠如、ポーズ/スタイル/背景を変更できない、訓練セットのディテールを繰り返すことによって特徴づけられます10。alpha/r 比率(実効LR)と訓練期間/エポック数に強く影響されます。ランクに対してalphaを低く設定すること(例:alpha=1, alpha=rank/2)は、alpha=rankと比較して過学習を軽減するためにしばしば推奨されます17。しかし、5/5は、特定のセットアップにおいて明らかな過学習問題なしに高いalphaがうまく機能したことを発見しており、文脈依存性を強調しています。

- 柔軟性: LoRAの概念を新しいプロンプト/スタイルと組み合わせる能力。過学習は柔軟性を低下させます40。キャラクターLoRAでは、柔軟性を維持するためにalpha=1やalpha=rank/2のような設定がしばしば好まれます51。

C. 視覚的な例とケーススタディ

- Zoomyizumi実験 50: キャラクターLoRAに対して様々なrank/alphaの組み合わせをテスト。

- (32, 32): 学習不足、キャラクター生成失敗。

- (86, 86): 「ちょうど良い」、良好な結果、最小限のアーティファクト。

- (128, 128): アーティファクトが再発。

- (128, 86): アーティファクト持続。

- (86, 128): アーティファクトなし、しかし深刻な解剖学的変形。

- 結論: 複雑な相互作用を示し、(86, 86)がその特定のケースで最適であった。後にalpha=rank2を推奨するように覆された50。[発見の矛盾/進化に注意]*

- Determined AIブログ 5: 彼らのタスク(text-to-SQL)において、特定のランク(r=2およびr=128)に対して、より高いalpha(例:512)が低いalphaよりも優れた精度を与えたプロットを示した。画像生成に関する視覚的な例はなし。

- Redditテスト 58: ユーザーが効果をテストし、Dim/Alphaが柔軟性や困難なデータセットの扱いに影響を与えることを示唆しているが、詳細は外部記事にある。

- 図式的表現 31: Alphaを更新に影響を与えるスケーリング係数として概念的に示しているが、出力の直接的な視覚比較ではない。

D. 本セクションの含意

Alphaが画像品質に与える影響は、ランク、学習率、訓練期間(エポック/ステップ)、そして特定の訓練データ/目標と密接に絡み合っています。単一の「低alpha = 良い」または「高alpha = 悪い」という規則は存在しません。実験は矛盾した結果を示しています。低いalpha/rankは学習不足になる可能性があり50、高いalpha/rankはアーティファクトや柔軟性の欠如を引き起こす可能性があります50。成功は、文脈に特有のバランスを見つけることにかかっています52。Zoomyizumiの実験50は、異なる組み合わせがいかに大きく異なる視覚的結果(学習不足、良好、アーティファクト、変形)を生み出すかを明確に示しています。

過学習対学習不足は、alphaが alpha/r を介して影響を与える実効的な学習強度によって調整される中心的なトレードオフです。柔軟性はしばしば過学習を防ぐことを必要とします。過学習は汎化能力の低下と柔軟性の欠如につながります40。多くの推奨事項はこれを防ぐことを目指しており、しばしばランクに対して低いalphaを提案します17。目標は通常、望ましい概念を捉えつつも、プロンプトによって依然としてガイドできるLoRAです10。Alphaは、更新強度をスケーリングすることによって5、モデルが訓練データにどれだけ速く、強く適応(潜在的には過剰適応)するかに直接影響を与えます。

視覚的なアーティファクトは、rank/alpha設定の極端さや不均衡に関連しているように見え、おそらく訓練の不安定性に関連しています。50は、高/高(128/128)と高ランク/低alpha(128/86)の両方でアーティファクトを報告し、低ランク/高alpha(86/128)で変形を報告しました。その特定のテストランでは、バランスの取れた(86/86)設定のみが大きな問題を回避しました。これは、ランクまたは alpha/r 比率を対応する調整なしに極端に押し進めると、学習プロセスが不安定になり、視覚的に質の低い結果につながる可能性があることを示唆しています。

VI. Network Alphaに関するコミュニティの実践、推奨、ガイドライン

A. 多様で矛盾する推奨事項

オンラインで見られるアドバイスが広範囲にわたり、しばしば矛盾していることを認識する必要があります5。普遍的なコンセンサスは存在しません。一般的に引用される比率/設定には以下が含まれます:

- alpha = rank: 元のLoRA論文で提案され5、一部で成功裏に使用されていますが22、柔軟性を欠く可能性があります51。

- alpha = rank / 2: 非常に一般的な推奨事項であり5、しばしば良好なバランスと見なされます。

- alpha = 1: 一部のガイドで推奨され41、ランクスケーリング(1/r または 1/sqrt(r))に対してLoRAの強度を最大化し17、rsLoRAに最適である可能性があり42、単純な概念/顔に適している場合がありますが41、慎重なLR調整が必要です。

- alpha = rank * 2: 言及されていますが2、詳細な正当化は少なく、時代遅れか特定の(おそらく古いLLM)文脈に特有かもしれません。50の著者は、当初rank=alphaが最良と発見した後、後にこれを支持しました。

- 固定Alpha(例:16または32): ランクに関係なく32。

- 高Alpha(例:256, 512): 低/中程度のランクと共に5。

B. 一般的な設定の根拠

- alpha = rank / 2: alpha=rankと比較して学習率をわずかに抑制し、過学習を減らし柔軟性を向上させつつ、依然として有意な学習を可能にすることを目的としています17。安全な出発点と見なされています。

- alpha = 1: 学習された重みの影響をランクスケーリング(1/r または 1/sqrt(r))に対して最大化します。強力な適応効果を意図しており、基盤モデルに大幅な変更が必要な場合や、高ランクが不要な単純な概念に有用な場合があります17。慎重なLR管理が必要です。

- alpha = rank: 学習された更新を 1/r でスケーリングして直接適用します。最も単純なアプローチであり、alphaを調整しないという元の論文の提案に従っています5。一部のユースケースでは強すぎる/柔軟性に欠ける可能性があります51。

C. LoRAユースケースに基づく推奨事項

- キャラクターLoRA: 異なるポーズ、服装、シーンに対する柔軟性を維持するために、ランクに対して低いalpha(例:alpha=1、alpha=rank/2、alpha=rank/4)を使用することがしばしば推奨されます41。ランクは単純な顔には低く(例:8-32)51、高忠実度の類似性には高く(例:64-256)40なる可能性がありますが、高ランクには注意が必要です(48は<=32から始めることを推奨)。ランク4で十分とする意見もあります54。52は96/1がうまく機能したと報告しています。48のユーザーは256/1がまあまあで、後に基盤モデル上で32/32が最良だったと発見しました。44はランク16が良い出発点であり、それより小さい可能性もあると示唆しています。Fluxではalpha=rankが一般的ですが、SDXLではalpha=1が有効でした。

- スタイルLoRA: 複雑な文体的要素を捉えるために、より高いランクが有益な場合があります28。Alphaの推奨は様々ですが、目標はしばしば強力なスタイル転送です。54は、64/32や32/2がスタイルに対して壊れていたと発見し、彼らのケースではalpha > 1が問題であったことを示唆しています。

- コンセプト/オブジェクトLoRA: ランク/alphaは複雑さに依存します。51は、柔軟性のためにランクに対して低いalphaを推奨しています(キャラクターと同様)。

提案テーブル:

タイトル: Stable Diffusion LoRAタイプ別 コミュニティ推奨 Rank/Alpha 開始点

| LoRAタイプ | 推奨Rank範囲 | 推奨Alpha設定 | 主要な考慮事項/トレードオフ | 関連情報源例 |

| キャラクター | 8 – 128+ | 1, rank/2, rank/4 | 柔軟性(ポーズ、服装変更) vs 忠実度(類似性)。低alpha推奨が多い。高ランクは過学習注意。 | 40 |

| スタイル | 32 – 128+ | rank/2, rank | スタイル強度 vs 汎用性。複雑なスタイルには高ランクが有効な場合あり。alpha > 1に注意の報告も。 | 28 |

| コンセプト/オブジェクト | 16 – 64+ | 1, rank/2 | 概念の明確さ vs 柔軟性。複雑さに応じて調整。キャラクター同様、低alpha推奨の場合あり。 | 51 |

注意: 上記は一般的な開始点の提案であり、最適値はデータセット、目標、その他の設定に大きく依存します。経験的なテストが不可欠です。

D. データセットと目標の影響

最適な設定は、訓練データの品質、量、一貫性に大きく依存します41。小規模または一貫性のないデータセットは、大規模でクリーンなデータセットとは異なる設定を必要とする場合があります48。特定の目標(例:正確な類似性対一般的なスタイル転送)は、忠実度と柔軟性の間の望ましいトレードオフに影響を与え、rank/alphaの選択に影響します46。

E. 実践的なワークフロー提案

- デフォルト/推奨のalpha(例:alpha=rankまたはalpha=rank/2)とランクで開始し、次に学習率を調整します5。

- 良好なLRが見つかったら、必要に応じてランクを調整し、alphaは一定に保つ可能性があります5。

- あるいは、LR調整を自動的に処理する可能性のある適応型オプティマイザ(Prodigy, DAdaptation)を使用し、alpha調整を簡略化することを検討します41。

- 特に高ランクを探索する場合は、rsLoRA(PEFTでuse_rslora=True)の使用を検討し、潜在的にalpha=1または固定のデフォルトalphaを使用します42。

- チェックポイントを頻繁に(例:エポックごと)保存し、生成画像をテストして最適なバランスを見つけ、過学習/学習不足を回避します40。

F. 本セクションの含意

コミュニティにおけるalphaに関する推奨事項の広範なばらつきは、複数の要因(ランク、LR、オプティマイザ、データ、タスク、基盤モデル、スケーリング関数)の複雑な相互作用と、普遍的に適用可能な理論の欠如から生じています。提示された情報源は、alpha=1からalpha=rank*2、固定alpha、高alphaなど、多岐にわたる推奨事項を示しています2。これは単なるノイズではなく、多様な訓練セットアップ全体で経験的に見出された最適な設定の真の違いを反映しています52。根底にあるメカニズム(alpha/rankスケーリング、LR相互作用)は複雑で文脈依存的です5。

alpha <= rank(特にrank/2または1)を設定するという一般的なアドバイスは、alpha=rankと比較して実効的な学習強度を低下させることにより、特にキャラクターLoRAにおいて過学習を制御し柔軟性を維持したいという願望から生じている可能性が高いです。ガイドはしばしばalpha=rank/2またはalpha=1を、より良い柔軟性とLoRAが基盤モデルを圧倒するのを避けることと関連付けています17。過学習は一般的な懸念事項であり40、alpha < rankを介して実効LRを低下させること47は、それを軽減するための妥当な戦略です。これは、訓練データへの最大の忠実度よりも、プロンプト全体での使いやすさを優先します。

適応型オプティマイザ(Prodigyなど)やrsLoRAのような新しい開発は、最適なalpha戦略をシフトさせる可能性があり、選択を簡略化したり、異なるデフォルト(rsLoRAの場合はalpha=1など)を支持したりするかもしれません。適応型オプティマイザはLRを自動調整できるため41、LRの代理としてalphaを手動で調整する必要性を減らす可能性があります。rsLoRAは基本的なスケーリング(alpha/sqrt(r))を変更するため、標準的なLoRAと比較して特定のランクに対する最適なalpha値が変わる可能性が高いです42。これは、ベストプラクティスが新しい技術と共に進化していることを示しています。

VII. 結論:画像品質のためのNetwork Alphaの最適化

A. Network Alphaの役割と影響の統合

Network Alphaは、LoRA更新の強度を調整するスケーリング係数(alpha/r または alpha/sqrt(r))として機能します。これは、訓練ダイナミクス(実効LRを介した安定性、収束速度)および最終的な画像品質(忠実度、ディテール、アーティファクト、柔軟性、過学習)に影響を与えます。その効果は、ネットワークランク、学習率、オプティマイザ、および訓練データ/目標から切り離すことはできません。

B. 主要なトレードオフの要約

- 忠実度 vs 柔軟性: より強力なLoRA効果(ランクに対して低いalpha、例:alpha=1、または高い実効LR)は忠実度を高める可能性がありますが、過学習と柔軟性の低下のリスクを伴います。より弱い効果は柔軟性を保持しますが、学習不足やディテールの欠如につながる可能性があります。

- 容量 vs 効率/安定性: 高いランクはより多くの容量を提供しますが、リソース要件と過学習リスクを高めます。Alphaはスケーリングを通じてランクと相互作用し、安定性に影響を与えます。

C. 経験的テストの決定的な重要性

複雑な相互作用と普遍的なルールの欠如のため、最適なalphaを見つけるには実験が必要です28。異なるalpha値(ランクとLRと共に)をテストし、様々な訓練段階(エポック/ステップ)で生成された画像を評価することが不可欠です40。視覚的な検査が鍵となります40。コミュニティのアドバイスや結果を解釈する際には、特定のユースケース(キャラクター、スタイル、コンセプト)とデータセットの特性を考慮する必要があります。

D. 最終的な推奨事項

- コミュニティのヒューリスティック(例:タスクと柔軟性対強度の好みに基づくalpha=rank/2、alpha=rank、alpha=1)と中程度のランク(例:16-64)から始めます。

- 選択したオプティマイザと初期のalpha/rankに対して、学習率を慎重に調整します。

- 調整を簡略化する可能性がある適応型オプティマイザまたはrsLoRAの使用を検討します。

- 特定のプロジェクト目標に対する最良のバランスを見つけるために、異なるチェックポイント間で視覚的な出力を繰り返しテストし、評価します。設定と結果を体系的に文書化することが推奨されます。

引用文献

- LoRA Fine-tuning & Hyperparameters Explained (in Plain English) | Entry Point AI, 4月 15, 2025にアクセス、 https://www.entrypointai.com/blog/lora-fine-tuning/

- LoRA: Low-Rank Adaptation for LLMs – Snorkel AI, 4月 15, 2025にアクセス、 https://snorkel.ai/blog/lora-low-rank-adaptation-for-llms/

- Stable Diffusion Quick Kit 动手实践-在SageMaker 中进行LoRA fine tuning 及推理 – AWS, 4月 15, 2025にアクセス、 https://aws.amazon.com/cn/blogs/china/lora-fine-tuning-and-reasoning-in-sagemaker/

- 使用LoRA 进行Stable Diffusion 的高效参数微调 – GitHub, 4月 15, 2025にアクセス、 https://github.com/huggingface/blog/blob/main/zh/lora.md

- Finding the best LoRA parameters – Determined AI, 4月 15, 2025にアクセス、 https://www.determined.ai/blog/lora-parameters

- LoRA – Hugging Face, 4月 15, 2025にアクセス、 https://huggingface.co/docs/peft/main/conceptual_guides/lora

- LoRA – Hugging Face, 4月 15, 2025にアクセス、 https://huggingface.co/docs/peft/v0.6.0/conceptual_guides/lora

- Improving LoRA: Implementing Weight-Decomposed Low-Rank Adaptation (DoRA) from Scratch – Sebastian Raschka, 4月 15, 2025にアクセス、 https://sebastianraschka.com/blog/2024/lora-dora.html

- LoRA Training in the NTK Regime has No Spurious Local Minima – arXiv, 4月 15, 2025にアクセス、 https://arxiv.org/pdf/2402.11867

- Fine-tuning with LoRA: create your own avatars & styles! – kix, 4月 15, 2025にアクセス、 https://www.kix.in/2023/04/07/sd-lora-finetuning/

- LoRA Learns Less and Forgets Less – arXiv, 4月 15, 2025にアクセス、 https://arxiv.org/html/2405.09673v1

- Using LoRA for Efficient Stable Diffusion Fine-Tuning – Hugging Face, 4月 15, 2025にアクセス、 https://huggingface.co/blog/lora

- Enable LoRA weights with Stable Diffusion Controlnet Pipeline – OpenVINO™ Blog, 4月 15, 2025にアクセス、 https://blog.openvino.ai/blog-posts/enable-lora-weights-with-stable-diffusion-controlnet-pipeline

- 全世界LoRA 训练脚本,联合起来! – GitHub, 4月 15, 2025にアクセス、 https://github.com/huggingface/blog/blob/main/zh/sdxl_lora_advanced_script.md

- Stable Diffusion Quick Kit 动手实践– 使用Dreambooth 进行模型微调在SageMaker 上的优化实践 – AWS, 4月 15, 2025にアクセス、 https://aws.amazon.com/cn/blogs/china/stable-diffusion-quick-kit-series-model-fine-tuning-with-dreambooth-optimization-practices-on-sagemaker/

- LoRA – Hugging Face, 4月 15, 2025にアクセス、 https://huggingface.co/docs/diffusers/v0.32.0/en/api/loaders/lora

- 3-2 LoRA Training (Advance) – SeaArt Guide, 4月 15, 2025にアクセス、 https://docs.seaart.ai/guide-1/3-advanced-guide/3-2-lora-training-advance

- Stable diffusion「LoRA」とは?おすすめも紹介 – AIsmiley, 4月 15, 2025にアクセス、 https://aismiley.co.jp/ai_news/what-is-stable-diffusion-lora/

- Master LoRA Art Training: A Guide for AI Creatives – Blibla, 4月 15, 2025にアクセス、 https://blib.la/blog/mastering-lora-style-training-a-comprehensive-guide

- LoRA Training | Moescape AI, 4月 15, 2025にアクセス、 https://docs.moescape.ai/image-generation-guide/lora-training

- Stable DiffusionのLoRAとは?checkpointとの違いは?概要、使い方、作成方法を徹底解説!, 4月 15, 2025にアクセス、 https://ai-market.jp/technology/stable-diffusion-lora/

- Single Block / Layer FLUX LoRA Training Research Results and LoRA Network Alpha Change Impact With LoRA Network Rank Dimension – Check Oldest Comment for Conclusions : r/civitai – Reddit, 4月 15, 2025にアクセス、 https://www.reddit.com/r/civitai/comments/1fl130j/single_block_layer_flux_lora_training_research/

- LoRA Training (Stable Diffusion 1.5) | ScottBaker.ca, 4月 15, 2025にアクセス、 https://www.scottbaker.ca/AI/LoRA-Training

- 推出高性能微调解决方案DoRA,LoRA 的替代选择 – NVIDIA Developer, 4月 15, 2025にアクセス、 https://developer.nvidia.com/zh-cn/blog/introducing-dora-a-high-performing-alternative-to-lora-for-fine-tuning/

- LoRA vs Full Fine-tuning: An Illusion of Equivalence – arXiv, 4月 15, 2025にアクセス、 https://arxiv.org/html/2410.21228v1

- LoRA – Hugging Face, 4月 15, 2025にアクセス、 https://huggingface.co/docs/diffusers/main/en/training/lora

- datascience.stackexchange.com, 4月 15, 2025にアクセス、 https://datascience.stackexchange.com/questions/123229/understanding-alpha-parameter-tuning-in-lora-paper#:~:text=%5B…%5D%20and%20LoRA,weight%20to%20the%20LoRA%20activations.

- Understanding Min SNR Gamma, Network Rank Dim, and Tokens in LoRA Training, 4月 15, 2025にアクセス、 https://wiki.shakker.ai/en/lora-min-snr-gamma-network-rank-alpha-tokens

- Understanding LoRA Adapters Rank and Alpha Parameters – Datawizz.ai, 4月 15, 2025にアクセス、 https://datawizz.ai/blog/understanding-lora-adapters-rank-and-alpha-parameters

- LoRA Parameters Encyclopedia – Unsloth Documentation, 4月 15, 2025にアクセス、 https://docs.unsloth.ai/get-started/beginner-start-here/lora-parameters-encyclopedia

- LoRA Alpha Parameter Diagram – Stable Diffusion Online, 4月 15, 2025にアクセス、 https://stablediffusionweb.com/image/18740004-lora-alpha-parameter-diagram

- transformer – Understanding alpha parameter tuning in LORA paper …, 4月 15, 2025にアクセス、 https://datascience.stackexchange.com/questions/123229/understanding-alpha-parameter-tuning-in-lora-paper

- diffusers/src/diffusers/models/lora.py at main · huggingface/diffusers – GitHub, 4月 15, 2025にアクセス、 https://github.com/huggingface/diffusers/blob/main/src/diffusers/models/lora.py

- Is LoRA Rank = Precision, Alpha = Strength relative to rank? : r/LocalLLaMA – Reddit, 4月 15, 2025にアクセス、 https://www.reddit.com/r/LocalLLaMA/comments/1bjzc75/is_lora_rank_precision_alpha_strength_relative_to/

- Eternal question: what rank (r) and alpha to use in QLoRA? : r/LocalLLaMA – Reddit, 4月 15, 2025にアクセス、 https://www.reddit.com/r/LocalLLaMA/comments/17pw7bv/eternal_question_what_rank_r_and_alpha_to_use_in/

- Barely any difference with network_alpha = 1 even on high lr · Issue #98 · kohya-ss/sd-scripts – GitHub, 4月 15, 2025にアクセス、 https://github.com/kohya-ss/sd-scripts/issues/98

- Clarification to Lora paper – finetuning alpha – Generative AI with Large Language Models, 4月 15, 2025にアクセス、 https://community.deeplearning.ai/t/clarification-to-lora-paper-finetuning-alpha/417123

- Network Rank, Network Alpha – Please explain in simple words if …, 4月 15, 2025にアクセス、 https://github.com/bmaltais/kohya_ss/issues/1511

- LoRA – Hugging Face, 4月 15, 2025にアクセス、 https://huggingface.co/docs/diffusers/v0.29.2/en/api/loaders/lora

- Are there any real guides to LORA training? : r/StableDiffusion – Reddit, 4月 15, 2025にアクセス、 https://www.reddit.com/r/StableDiffusion/comments/16rt86a/are_there_any_real_guides_to_lora_training/

- I read an article on rentry about training loras and the author recommends training with alpha = 1. Is this value too low? If alpha slows down training, why use such a low value? What is the difference between using alpha = 1 and alpha = half of dim? : r/StableDiffusion – Reddit, 4月 15, 2025にアクセス、 https://www.reddit.com/r/StableDiffusion/comments/1eorb8z/i_read_an_article_on_rentry_about_training_loras/

- rslora guidance for alpha value? · huggingface peft · Discussion #1387 – GitHub, 4月 15, 2025にアクセス、 https://github.com/huggingface/peft/discussions/1387

- Whats the best alpha dimension for LoRA : r/StableDiffusion – Reddit, 4月 15, 2025にアクセス、 https://www.reddit.com/r/StableDiffusion/comments/18udeot/whats_the_best_alpha_dimension_for_lora/

- Best Dim / Alpha for Flux Lora? : r/StableDiffusion – Reddit, 4月 15, 2025にアクセス、 https://www.reddit.com/r/StableDiffusion/comments/1fhfv3f/best_dim_alpha_for_flux_lora/

- Some useful discussion on LORA training w/ Onetrainer from their github : r/StableDiffusion, 4月 15, 2025にアクセス、 https://www.reddit.com/r/StableDiffusion/comments/1e7g9zv/some_useful_discussion_on_lora_training_w/

- How to create an original character LoRA [SD1.5 Training] SD1.5 Character Training, 4月 15, 2025にアクセス、 https://www.digitalcreativeai.net/en/post/original-character-lora-sd15-character-training

- Network Alpha – Civitai Wiki, 4月 15, 2025にアクセス、 https://wiki.civitai.com/wiki/Network_Alpha

- Feedback and recommendations for LoRA training settings : r/StableDiffusion – Reddit, 4月 15, 2025にアクセス、 https://www.reddit.com/r/StableDiffusion/comments/1jpyibp/feedback_and_recommendations_for_lora_training/

- How to Train a Highly Convincing Real-Life LoRA Model – MyAIForce, 4月 15, 2025にアクセス、 https://myaiforce.com/real-life-lora-training/

- LoRA experiment 7: A basic look at Network Rank and Network …, 4月 15, 2025にアクセス、 https://www.zoomyizumi.com/lora-experiment-7/

- Network rank (DIM) and Alpha rank? : r/StableDiffusion – Reddit, 4月 15, 2025にアクセス、 https://www.reddit.com/r/StableDiffusion/comments/1g8gmm8/network_rank_dim_and_alpha_rank/

- Best network rank and alpha value for fidelity and lora compatibility? and another question… : r/StableDiffusion – Reddit, 4月 15, 2025にアクセス、 https://www.reddit.com/r/StableDiffusion/comments/16py4ft/best_network_rank_and_alpha_value_for_fidelity/

- Lora rank vs Lora Alpha · axolotl-ai-cloud axolotl · Discussion #1133 – GitHub, 4月 15, 2025にアクセス、 https://github.com/axolotl-ai-cloud/axolotl/discussions/1133

- Lora training question : r/StableDiffusion – Reddit, 4月 15, 2025にアクセス、 https://www.reddit.com/r/StableDiffusion/comments/1b7h10a/lora_training_question/

- The Effects Of Rank, Epochs, and Learning Rate on Training Textual LoRAs – RunPod Blog, 4月 15, 2025にアクセス、 https://blog.runpod.io/the-effects-of-rank-epochs-and-learning-rate-on-training-textual-loras/

- Takeaways from hundreds of LLM finetuning experiments with LoRA – Hacker News, 4月 15, 2025にアクセス、 https://news.ycombinator.com/item?id=37870930

- LoRA training parameters · bmaltais/kohya_ss Wiki – GitHub, 4月 15, 2025にアクセス、 https://github.com/bmaltais/kohya_ss/wiki/LoRA-training-parameters

- I tested the effects of Network Dimension and Network Alpha …, 4月 15, 2025にアクセス、 https://www.reddit.com/r/StableDiffusion/comments/1535k37/i_tested_the_effects_of_network_dimension_and/