はじめに

課題の概要

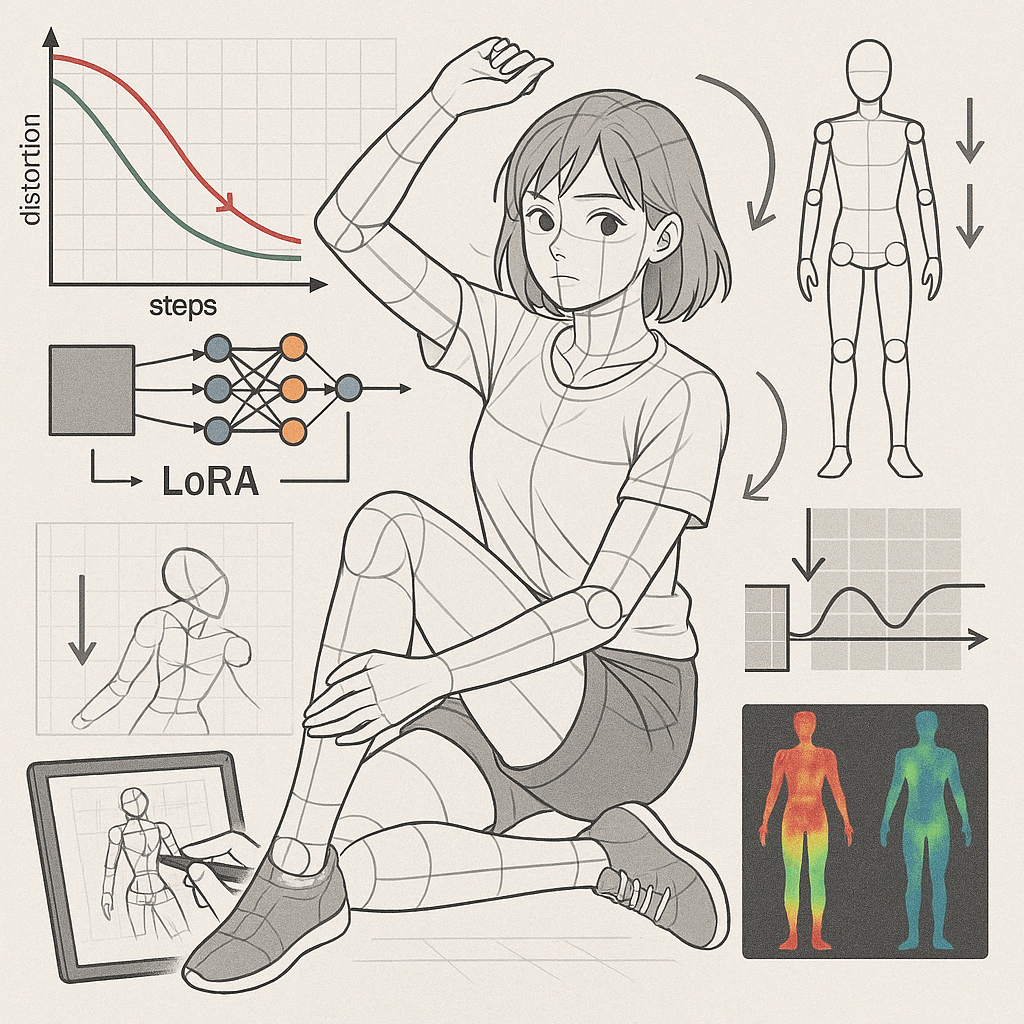

Stable Diffusionをはじめとする画像生成AIフレームワークにおいて、Low-Rank Adaptation(LoRA)モデルを複雑なシーン、ポーズ、あるいは詳細な被写体についてトレーニングする際に、人体の破綻(例えば、手足の奇形、指の数の異常、顔貌の歪み、身体部位の不自然な融合など)が頻繁に観察される。この問題は、特にキャラクター中心のアートワークや入り組んだ構図を持つ高忠実度画像の信頼性の高い生成を妨げる要因となっている。

本レポートの目的

本レポートは、この人体構造の不安定性の根本原因について厳密かつエビデンスに基づいた分析を提供し、技術研究および確立されたコミュニティの知見から導き出された実践的な戦略、ベストプラクティス、および軽減技術の詳細なセットを提示することを目的とする。

方法論

本レポートは、LoRAトレーニングおよびStable Diffusion画像生成に関連する学術論文、技術文書、開発者ガイド、およびコミュニティ(フォーラム、Redditなど)における議論から得られた知見を統合したものである。

第1章:LoRAにおける人体破綻の診断

1.1 一般的な兆候

人体破綻の具体的な視覚的例としては、余分な、あるいは欠損した手足や指、分離した身体部位、意図した被写体と一致しない歪んだ顔貌、不可能なポーズ、衣服や背景要素と不自然に融合する身体部位などが挙げられる。これらの問題は、LoRAが被写体間の複雑な相互作用、入り組んだ衣服、または動的なポーズを学習しようとする場合に、より顕著になる傾向がある。

1.2 根本原因分析

1.2.1 過学習と特徴量の絡み合い(Overfitting and Feature Entanglement)

LoRAの文脈における過学習とは、モデルがトレーニングデータ内の特定の詳細(欠陥やノイズを含む)を過度に記憶し、汎化能力を失う現象を指す。特徴量の絡み合いとは、LoRAが関連性のない概念を誤って関連付けてしまうことである(例:特定のポーズが常に特定の服装と結びつく、あるいは解剖学的な誤りが対象の被写体やスタイルと結びつく)。

特に衣服などの詳細の再現性を高めようとして学習ステップ数を増やすと、過学習のリスクが高まることが指摘されている 1。ステップ数の増加は、モデルを特定の訓練例に対してより敏感にし 2、意図した特徴だけでなく、データセット内のノイズや見せかけの相関関係も学習してしまう。推論時にわずかに異なるプロンプトが与えられると、モデルはこれらの学習された欠陥のある「ルール」を適用し、結果として人体構造の誤りを引き起こす。例えば、限られた、あるいは欠陥のある例しか見ていないために、特定の腕の位置が常に肩を歪ませるとモデルが誤解する可能性がある。高いネットワークランク(次元)の設定も過学習を引き起こす可能性がある 4。多くの画像を使いすぎることが過学習(overcooking)を引き起こす可能性も指摘されている 5。学習率が高すぎると過学習を招く可能性がある一方、エポック数を増やすと過学習のリスクが高まる 6。小規模なデータセットでの長時間の学習も過学習につながる 7。

1.2.2 データセットの限界

トレーニングデータセット内の問題が、人体破綻の主要な原因となる。これには、不十分な品質(ぼやけた画像、アーティファクト)、多様性の欠如(限られたポーズ、アングル、照明)、内在するバイアス(ソース画像における一貫した軽微な解剖学的欠陥)、および不正確または不十分なタグ付け/キャプションが含まれる。

データセットはLoRAトレーニングにおいて極めて重要であり 8、多様な画像(ポーズ、アングル、服装、背景)を用意することが推奨される 5。特に複雑な構図では、より多様で高品質なデータが不可欠となる。単純なポートレートには十分なデータセットでも、動的なシーンには著しく不足している場合があり、多様性や品質の低さによる悪影響が増幅される。これは、モデルが様々な文脈における正しい人体構造の十分な例を持たないため、直接的に人体破綻につながる。例えば、正面からのポーズしかない場合 5、モデルは他の視点やポーズでの人体の挙動を学習できない。未知のポーズや構図を要求された場合、モデルは限られたデータに基づいて不適切に外挿し、人体構造の誤りを引き起こす。低品質な画像 8 はノイズを加え、特に過学習中にモデルがこれを解剖学的特徴として誤解する可能性がある。データセットには、AIが解釈に困るような複雑な要素や生成が難しい要素を含めないことが望ましい 5。

1.2.3 パラメータの競合と不安定性

最適でないハイパーパラメータ設定(学習率、ランク、アルファ、ステップ数、オプティマイザの選択)は、不安定なトレーニング、勾配の問題、あるいは適切な収束の失敗につながり、人体構造の歪みを含む視覚的アーティファクトとして現れる可能性がある。特にアルファのようなパラメータに関しては、しばしば矛盾した推奨が見られる 11。

バッチサイズや学習率が安定性に影響を与える可能性がある 2。ネットワークランクとアルファは、学習する詳細度や学習の集中度に影響する 12。パラメータの感度が高く、不安定になる可能性がある 13。学習率、エポック数、ランク、アルファのトレードオフが過学習や学習不足に影響する 6。アルファに関する矛盾したアドバイスや、学習率およびランクとの関係性、ランク上昇に伴う安定性のためのrsLoRA(rank-stabilized LoRA)の導入などが議論されている 11。特定のオプティマイザ(AdaFactor、DAdaptAdanIPなど)がスタイルLoRAとキャラクターLoRAで異なる適性を持つ可能性があり、オプティマイザの選択が安定性や学習の焦点に影響することを示唆している 1。

これらのパラメータは独立変数ではない。最適な学習率は、選択されたランク、アルファ、オプティマイザ、およびデータセットのサイズ/複雑さに依存する 8。これらを個別に扱ったり、文脈(オプティマイザ、ベースモデル、タスクの難易度)を考慮せずに単純なルール(例:「アルファ = ランク * 2」)に従ったりすると、人体構造の詳細を正しく捉えられない、あるいは不安定性を引き起こすような最適でないトレーニングダイナミクスにつながる可能性がある。矛盾したアドバイス自体 11 が、この複雑さを浮き彫りにしている。例えば、一般的なアドバイス(例:アルファ=16固定 14)に従ってパラメータを設定すると、他の設定(非常に高いランクや特定のオプティマイザ)と競合する可能性がある。パラメータ間の相互作用が不安定な勾配や収束不良 11 を引き起こし、モデルが人体構造の微細な詳細を正しく学習できなかったり、更新中にノイズ/アーティファクトを導入したりする。結果として得られるLoRAは、人体構造の誤りを生成する。rsLoRA 11 のような技術の登場は、ランクとスケーリング因子の相互作用から生じる不安定性に直接対処するものである。

1.2.4 構図の複雑性の影響

複雑なシーン(複数の相互作用する被写体、短縮法、珍しい視点、前景の被写体と相互作用する詳細な背景)を表現すること固有の難しさが、LoRAおよびベースモデルの能力に負担をかけ、良好なデータとパラメータを用いても人体構造の誤りをより起こりやすくする。

複雑な構図が直接的な破綻の原因であると明示する資料は少ないものの、ユーザーの問い合わせやデータセットの要件(多様なアングルや文脈の必要性 5)、詳細のためのパラメータ調整 6 に関する議論から、その関連性は暗黙的に示唆されている。Stable Diffusion自体の限界として、複雑なシーンや人体構造の描写が挙げられている 15。SD 3.5も複雑なプロンプトにおける物体の一貫性や人体構造に苦労することがある 16。

LoRAは既存のモデルを変更するものである。複雑な構図は、ベースモデルの空間的関係と人体構造の理解 15、およびLoRAが限られたパラメータでこれらの表現を適応させる能力の両方の限界を押し上げる。複雑さ自体がストレス要因として作用し、単純な生成では明らかにならないかもしれないベースモデルやトレーニングプロセスの弱点を露呈させる。ユーザーが複雑な構図を求めると、モデルは複雑な空間関係、オクルージョン、様々な条件下での人体構造を理解する必要がある。ベースモデルは、そのような複雑さを表現する上で固有の弱点を持っている可能性がある 15。限られたパラメータ予算を持つLoRA 17 は、これらの潜在的に弱い表現を適応させようとする。適応プロセスは、モデルをその固有の能力や学習されたバイアスを超えて強制しようとする際に、不十分であったり、エラーを導入したりする可能性がある。モデルがプロンプトの複雑さ、LoRAのガイダンス、およびベースモデルの限界を調和させようと苦闘する中で、人体構造の誤りが現れる。

第2章:人体構造の整合性を保つための戦略的データセット準備

2.1 画像選択:品質、解像度、焦点

高品質なソース画像の使用は絶対不可欠である。シャープで、良好な照明条件で、アーティファクトがなく、理想的には高解像度の画像が必要である 8。最低解像度はベースモデルに依存する(例:SD1.5では512×512、SDXL/Fluxでは1024×1024) 5。画像は被写体に焦点を当てるべきである 8。

クロッピング戦略(キャラクターにはフォーカスクロップ 5、Fluxには1:1比率 8)が推奨される。ソース画像を慎重にアップスケール/ノイズ除去することも有効な場合がある 20。LoRAの主題でない限り、AIが生成に苦労するような曖昧な要素や部分を含む画像は避けるべきである 5。

2.2 多様性のためのキュレーション:ポーズ、アングル、文脈

複雑なシーンにおける人体構造の安定性にとって、多様性がなぜ重要かを説明する必要がある。モデルは、様々なポーズ(立位、座位、アクション 1)、アングル(正面、側面、背面、上方、下方 1)、距離(全身、上半身、クローズアップ 1)、服装 5、表情 5、背景 5 にわたって、被写体の人体構造が正しく表現されているのを見る必要がある。

このスペクトルをカバーする画像を収集することが推奨される。タグが異なっていても、類似した画像を多用しないよう警告されている 5。モデルが基盤となる人体構造をより良く学習するのを助けるために、ヌードや体にフィットした衣服の画像を含めることが提案されている 19。

2.3 高度なキャプション/タグ付け技術

タグは、AIに画像の内容を教えるために使用される 5。

トリガーワードと記述タグの区別は極めて重要である。トリガーワードはLoRAを起動し、核となる一貫した概念(例:キャラクター名、特定のスタイル)を表す 5。これらの一貫した特徴(例:キャラクターの髪の色、常に着用している特徴的な服装)は、記述タグに含めるべきではない 5。記述タグは、推論時にユーザーが変更したい可能性のある可変要素(ポーズ、表情、背景、一時的な服装)を記述する 20。

自動生成されたキャプション(BLIP、Deepbooru 5)を手動でレビューし編集することが強く推奨される。不要/不正確なタグを削除し、一貫した特徴のタグを削除(トリガーワードの概念に移行)、可変要素を記述する重要なタグが欠落していれば追加する 3。コミュニティのコンセンサスは、品質のために手動キャプションを強く支持している 20。

シンプルだが正確なタグが推奨される 21。最大限の柔軟性が目標でない限り、過度に複雑な「ディープキャプション」は避けるべきである。これは核となる概念を希薄化させる可能性があるためである 21。適切なタグ付け閾値を設定する(5では0.5-0.8が推奨)。専門的なタガー(例:アニメ用Deepbooru 5)やタグ生成/補完のためのLLM 23 の使用を検討する。

正確なタグ付けは、人体構造の整合性にとって不可欠である。一貫した解剖学的特徴をタグ付けせず(暗黙的にトリガーワードに関連付ける)、ポーズや特定の衣服アイテムのような可変要素を正確にタグ付けすることで、トレーナーはAIを誘導し、キャラクターの「形態」をその「文脈」とは別に学習させる。不正確または欠落したタグは、AIが解剖学的特徴をポーズや衣服と誤って関連付ける原因となり、それらの文脈要素が変化したときに歪みを引き起こす。ユーザーがキャラクターLoRAを望む場合、キャラクターには一貫した特徴(顔、基本的な体型)と可変的な特徴(ポーズ、服装)がある。トリガーワードは一貫した本質を捉えるべきであり 5、タグは可変的な文脈を記述すべきである 21。もし一貫した特徴(例:特定の肩の形状)がタグ付けされると、AIはそれらを可変的なものとして扱い、キャラクターの核となる人体構造を失う可能性がある。もし可変的な特徴(例:複雑なポーズ)が正確にタグ付けされない場合、AIはポーズの人体構造への影響を誤ってキャラクターの核となる本質(トリガーワードに関連付けられる)に統合してしまうかもしれない。異なるポーズでキャラクターを生成する際、AIは誤って学習した人体構造の歪みを適用する。トリガーワードとタグによる正確な分離が、文脈から独立した安定した人体構造を学習するための鍵となる。

2.4 最適なデータセットサイズの考慮事項

LoRAの種類と複雑さに基づいて範囲を提供する。一般的なLoRA:20~40枚 5。キャラクターLoRA:通常25~40枚で十分 5、一部では30~100枚が推奨される 10。スタイルLoRA:望ましい柔軟性に応じて15~50枚以上 5。

「量より質」を強調する 5。画像の枚数が多ければ良いLoRAになるとは限らない 5。画像が多すぎると過学習のリスクが高まる可能性があり 3、より多くのリソース/時間が必要になる 8。トレーニング初心者の場合は、少なめ(20~30枚)から始めることが推奨される 8。最低枚数は10~15枚程度と言及されている 3。

複雑な構図の場合、単純な被写体と比較して、わずかに大きく、非常に多様で、綿密にタグ付けされたデータセットが必要になる可能性がある。しかし、単に類似した画像を追加するだけでは助けにならず、過学習を悪化させる可能性がある。重要なのは、構図の複雑さに関連する「意味のある変動」を増やすことであり、単なる生データの数ではない。複雑な構図は、より多様な状況での人体構造の学習を必要とする。これは、これらの状況をカバーするためにより多くのデータポイントが必要であることを示唆する。しかし、LoRAはデータが多すぎる、またはステップ数が多すぎると過学習しやすい 3。したがって、データセットのサイズは慎重にバランスを取る必要がある。サイズを増やすことは、追加された画像が新しい、関連性のあるバリエーション(異なる複雑なポーズ、相互作用)を導入し、かつ高品質である場合にのみ有益である。冗長な画像を追加することは、トレーニング時間と過学習リスクを増加させるだけである。複雑なLoRAの最適なサイズは、単純なものよりもわずかに大きい可能性があるが、それは増加が関連する多様性と品質の比例的な増加に対応する場合に限られる。

第3章:安定性と詳細のためのLoRAパラメータの微調整

3.1 学習率(Learning Rate, LR)の最適化

学習率は適応速度を制御する。高すぎると不安定性/過学習、低すぎると学習が遅い/品質が低い 2。典型的な範囲は1e-4から5e-5 2。スケジューラ(constant、cosine_with_restarts、linear decay)を使用する 6。手動調整を減らし過学習を防ぐために、適応的LRを持つオプティマイザ(Adafactor、DAdaptation)を検討する 1。デフォルト/推奨LRから始め、結果に基づいて調整する 11。ウォームアップステップは初期トレーニングの安定化に役立つ可能性がある 6。LRはアルファとランクと強く相互作用する 11。アルファの調整はLRの調整と類似の効果を持つことがある 11。

3.2 ネットワークランク(r)とアルファ(α):詳細と安定性のバランス

ランク(r)はLoRAの容量/詳細レベルを制御する 6。ランクが高いほどパラメータが多く、ファイルサイズが大きくなり、潜在的により詳細だが過学習リスクも高まる 4。典型的な範囲は8~128(しばしば2のべき乗) 6。SDXLはSD1.5よりもランクに敏感でない可能性がある 12。推奨される開始点:8~32 6。

アルファ(α)はLoRA更新のスケーリング係数である 6。しばしばランクと等しいか2倍に設定される 6。アルファが高いと学習強度が増すが、過学習を促進する可能性がある 6。ランクに関係なくアルファを固定(例:16)することを主張する意見もあるが 14、特定のランクに対してより高いアルファがより良い性能を示すという研究もある 11。LRとの相互作用が鍵となる 11。

高度な概念として、LoRA+は行列AとBに異なるLR(Bの方が高い)を使用し、潜在的により良い効率/性能を目指す 24。VeRAは共有ランダム行列と学習可能なスケーリングベクトルを使用し、LoRAと比較して訓練可能なパラメータを大幅に削減しつつ性能を維持する 17。rsLoRAは異なるスケーリング係数(\( \alpha/\sqrt{r} \) vs \( \alpha/r \)) を使用し、ランク増加に伴う安定性と性能スケーリングを改善する 11。

これら3つのパラメータ(ランク、アルファ、学習率)は、LoRAが人体構造的に破綻することなく複雑な詳細を学習する能力に影響を与える重要な三つ組を形成する。高いランクは容量を提供するが、不安定性や過学習を避けるためには慎重なLR/アルファのバランスが必要である。高いアルファは学習を促進するが、LRを低くするかステップ数を減らす必要がある。rsLoRA/LoRA+/VeRAは、このバランスを管理するための代替アプローチを提供し、複雑な構図に対してより良い安定性で高いランクや高速なトレーニングを可能にする可能性がある。アルファに関する矛盾したアドバイス 11 は、実験で使用された異なるベースモデル、オプティマイザ、タスクに起因する可能性が高く、固定されたルールではなく文脈に応じた調整の必要性を裏付けている。複雑な人体構造は微細な詳細の学習を必要とする。高いランク(r)は詳細を捉えるためのより多くのパラメータを提供する 6。しかし、高いランクは、特に標準的なLoRAスケーリング(\( \alpha/r \)) では不安定性や過学習につながる可能性がある 4。アルファ(α)は更新をスケーリングする。高いアルファは学習を強化するが、LRが調整されなければ不安定性/過学習を悪化させる可能性がある 6。学習率(LR)は、選択されたランク、アルファ、オプティマイザに対して適切である必要がある 11。rsLoRA(ランクに伴うスケーリングを改善 11)、LoRA+(A/Bで異なるLR 24)、VeRA(パラメータ削減 17)のような技術は、このトレードオフを最適化することを目指しており、複雑な詳細のより良い学習を、改善された安定性または効率で可能にする可能性がある。したがって、複雑なシーンでの人体破綻に取り組むことは、これらの高度なLoRAバリアントを探求するか、r/α/LRの三つ組を慎重に共同調整すること(おそらく、より高いランク/アルファでより低いLRを使用するか、rsLoRAを活用すること)を含むかもしれない。

3.3 トレーニング期間(ステップ数/エポック数)の管理

ステップ数/エポック数が多いほど学習が進むが、過学習リスクも高まる 1。総ステップ数は、画像数 * 繰り返し数 * エポック数に基づいて計算される 8。概念を学習するのに十分だが、「焼き付き(overcook)」しない程度のバランスを目指す 3。画像あたりの推奨ステップ数は様々である(例:SDXLでは画像あたり100ステップ 8)。総ステップ数はしばしば2000~4000の範囲である 1。「Nステップ/エポックごとに保存」(例:2~5エポック 12、250ステップ 8)を使用して中間LoRAをテストし、過学習が人体構造を損なう前のスイートスポットを見つける。TensorBoardの損失グラフを使用してトレーニングを監視し、最適なポイントを特定する 19。

3.4 正則化手法

ドロップアウトは過学習を防ぐことができる 6。LoRAドロップアウトパラメータが利用可能である 6。Unslothはドロップアウト0が最適化されていると示唆している 6。重み減衰(Weight Decay)は大きな重みを罰することで過学習を防ぐ 6。

正則化画像の使用については議論がある。一部のツールでは、トレーニング対象のクラス(例:「女性」)を保持するために正則化画像を指定できる。しかし、9は、単一概念のLoRAには使用しないことを主張している。目標は特化であり、一般的なクラスの保持ではないためである。これは、LoRAの目的であるターゲット適応と一致する 18。

ドロップアウト/重み減衰は標準的な正則化技術であるが、LoRAにおける正則化画像の使用は議論の余地がある 9。LoRAに一般的なクラスを記憶させることは、複雑な被写体に必要な正確な解剖学的学習を含む、特定のキャラクターやスタイルの学習を妨げる可能性がある。これは、単一概念のLoRAにおいて、正則化のためにパラメータ調整(LR、ステップ数)やデータセットの品質に依存する方が効果的かもしれないことを示唆している。

3.5 異なるベースモデル(SD1.5 vs. SDXL/Flux)へのパラメータ適応

SDXL/Fluxは一般的にSD1.5(512×512または768×768)と比較して高解像度データセット(1024×1024)を必要とする 5。SDXLはネットワークランク/アルファの変更に対してSD1.5ほど敏感でない可能性がある 12。Fluxは1:1のアスペクト比データセットを必要とする 8。画像あたりのステップ数などのトレーニング設定が異なる場合がある(例:SDXL時代の経験則として画像あたり100ステップ 8)。ベースモデルの選択はLoRAの互換性と性能に影響する 9。

特定のベースモデル世代(SD1.5、SDXL、Flux、SD3.5など)に推奨されるパラメータから始めることが推奨される。選択したベースモデルの特性に基づいてパラメータを調整する準備が必要である。

表1:複雑な構図を持つキャラクターLoRAのためのパラメータ調整ガイドライン

| パラメータ | SD1.5 開始点/範囲 | SDXL/Flux 開始点/範囲 | 人体構造/複雑性への影響 | 主要な出典/根拠 |

| 学習率 (LR) | 1e-4 ~ 5e-5 | 1e-4 ~ 5e-5 (Fluxはより低いLRを好む可能性あり) | 高すぎると不安定/過学習(破綻)、低すぎると学習不足(詳細欠如) | 2 |

| スケジューラ | constant (初期確認), cosine_with_restarts (高品質) | constant (初期確認), cosine_with_restarts (高品質) | 学習率の動的調整。過学習抑制や品質向上に寄与。 | 6 |

| オプティマイザ | AdamW, AdamW8bit, Adafactor, DAdaptation | AdamW, AdamW8bit, Adafactor, DAdaptation | 安定性、学習効率、過学習耐性に影響。Adafactor等はLR自動調整 1。 | 1 |

| ネットワークランク (r) | 8~64 (影響大) | 8~32 (影響小の傾向) | 高いほど詳細を捉えるが、ファイルサイズ増大、過学習リスク増 4。複雑な構造には高いランクが必要な場合も。 | 6 |

| ネットワークアルファ (α) | r/2 ~ r (影響あり) | 4 ~ 16 (影響小の傾向) | 学習強度を調整。高すぎると過学習促進。LRとのバランスが重要 11。 | 6 |

| ステップ数/エポック数 | 画像あたり数十~100ステップ、総計2000-4000程度 | 画像あたり100ステップ目安 8、総計2000-4000程度 | 多すぎると過学習(破綻)、少なすぎると学習不足(詳細欠如)。中間セーブでの確認が重要 3。 | 3 |

| データセット解像度 | 512×512, 512×768, 768×512 (768×768も可) | 1024×1024 (Fluxは1:1必須 8) | ベースモデルのネイティブ解像度に合わせることで学習効率と品質が向上。 | 5 |

注:上記は一般的な開始点であり、特定のデータセットや目標に応じて調整が必要です。rsLoRA、LoRA+、VeRAなどの高度な手法も検討の価値があります。

第4章:ベースモデルの選択とLoRAの堅牢性への影響

4.1 ベースモデルとLoRAの相互作用

LoRAはベースモデルの既存の重みを変更する 18。ベースモデル固有の能力、バイアス、およびトレーニングデータは、LoRAがどの程度うまくトレーニングされ、どのように機能するかに大きく影響する 9。LoRAの互換性は、LoRAをベースモデルアーキテクチャ(SD1.5、SDXLなど)に一致させることに依存する 18。

ターゲットとする生成スタイル/ドメインに近いベースモデルでLoRAをトレーニングすることが推奨される 21。SD1.5やSDXL-baseのような基盤モデルを使用すると、それらから派生した様々な微調整済みチェックポイント間での互換性が向上する可能性がある 9。特異性が望ましい場合は、過度に多様なベースモデルを避ける 21。

4.2 人体構造の一貫性のためのベースモデル評価

異なるベースモデルは、固有の人体構造理解と安定性のレベルが異なる。Flux.1 26 や潜在的にSD3.5 26 のような新しいモデルは、古いモデルよりも優れたベースラインの人体構造レンダリングを提供する可能性があるが、依然として苦労することもある 16。一部のモデルは特に指の安定性で注目されている 27。特定のチェックポイントはポーズの安定性が高い場合がある 28。リアルな人物LoRAのトレーニングにはRealistic Visionが推奨される 21。

複雑な構図を意図したLoRAをトレーニングするためのベースモデルを選択する際には、人体構造のレンダリング、複雑なプロンプトの処理、および全体的な一貫性における既知の長所/短所を考慮する 16。関連する複雑なプロンプトを使用してベースモデル自体で生成をテストする。

ベースモデルは単なる受動的なキャンバスではなく、能動的な参加者である。その固有の人体構造知識(またはその欠如)は、LoRAが構築する基盤を形成する。ベースモデルが特定のポーズや解剖学的構造に根本的に苦労する場合、LoRAはそれらを修正または適応させるのがはるかに困難になり、特に複雑な構図の負担の下で破綻の可能性が高まる。人体構造の安定性がより優れていることで知られるベースモデル(例:潜在的にFlux 26)を選択することは、より堅牢な出発点を提供する可能性がある。LoRAはベースモデルを適応させる 18。ベースモデルは、人体構造レンダリングを含む能力が異なる 16。複雑な構図はこれらの能力に負荷をかける。ベースモデルが人体構造に弱い場合、LoRAはその限られたパラメータ 17 を使用して補うためにより多くの作業を行う必要がある。これにより、失敗したり、新しいエラーを導入したりする可能性が高まる。したがって、本質的により良い人体構造理解を持つベースモデルを選択することは、より強力な基盤を提供し、LoRAが人体構造の破綻なしに複雑な構図を学習しやすくする。

第5章:トレーニング後の軽減策:推論時の出力の改善

5.1 戦略的なLoRAウェイト調整

推論中にLoRAの影響力をウェイト乗数(しばしば <lora:name:weight>)を使用して変更する 8。通常、0(効果なし)から1(完全な効果)の範囲だが、時にはそれ以上または負の値になることもある 8。

LoRAがベースモデルを圧倒し、スタイルの焼き付きや人体構造の歪みを引き起こしている場合は、ウェイトを減らす(例:0.5~0.8へ) 29。LoRAの効果が弱すぎる場合は、慎重にウェイトを上げる。LoRAの忠実度とベースモデルの安定性のバランスを取るためにウェイトを微調整する。これは複数のLoRAを組み合わせる際に特に重要である 29。

5.2 ネガティブプロンプトとエンベディングの効果的な使用

ネガティブプロンプトで特定のキーワード(bad anatomy, deformed, extra fingers, disfigured, long neck, long body など)を使用して、人体構造の誤りのような望ましくない特徴を抑制する 31。

ネガティブプロンプト内の特定の単語によってトリガーされる事前トレーニング済みエンベディング(例:EasyNegative, DeepNegative, negative_hand, bad_prompt)を使用して、全体的な品質を向上させ、人体構造の問題を含む一般的な欠陥を減らす 35。

ネガティブエンベディングは「悪い」特徴を表すようにトレーニングされる 35。一部は元のモデルのスタイルを変更する可能性があるが 36、それを保持することを目指すものもある(negative_hand 36)。望ましいスタイル(アニメ対リアル 36)に適したエンベディングを選択する。これらは100%の修正を保証するものではないが、大幅に役立つ可能性がある 36。

ネガティブプロンプトとエンベディングは強力なクリーンアップツールであるが、根本的には予防的というよりは修正的である。これらは、モデルがそうでなければ陥る可能性のある失敗モードから生成を遠ざけることによって機能する。基盤となるLoRAまたはベースモデルが、不十分なトレーニングや固有の制限により深刻な解剖学的欠陥を持っている場合、ネガティブガイダンスはそれらを完全に修正するのに苦労する可能性があり、時には問題を正しくレンダリングするのではなく、問題のある領域(手など 37)を隠すことに頼ることもある。これらは、適切にトレーニングされたLoRAと安定したベースモデルと組み合わせて使用するのが最適である。推論中に人体構造の誤りが発生する。ネガティブプロンプト/エンベディングは、拡散プロセスをこれらの誤りから「遠ざける」ように導く 31。これにより、軽微な誤りが抑制されたり、全体的な品質が向上したりする。しかし、LoRAが根本的に間違った解剖学的相関関係を学習した場合(過学習/不良データによる)、モデルのエラーへの傾向は強い。ネガティブガイダンスは部分的にしか修正できないか、ネガティブな制約を満たすためにモデルを不自然な解決策(例:手を隠す 37)に強制する可能性がある。したがって、欠陥のあるトレーニングによって引き起こされる深刻な解剖学的問題を修正するためにネガティブプロンプト/エンベディングだけに頼ることは、しばしば不十分である。これらは価値のある「軽減」レイヤーであり、優れたトレーニング慣行の代替ではない。

5.3 LoRAの組み合わせ:相乗効果と競合

キャラクターLoRAをスタイルLoRA、衣服LoRA 42、あるいは人体構造修正用LoRA 43 と組み合わせる可能性がある。LoRA合成方法が存在する(マージ、スイッチ 42)。

複数のLoRAを組み合わせると、それらの効果が衝突したり、ウェイトが高すぎたりすると、競合や画像の劣化/破綻につながる可能性がある 29。慎重なウェイトバランスが必要である 29。マルチLoRAサービングを最適化する研究も存在する 46。手のような特定の部分を改善するための専門的なLoRAが存在する 44。

5.4 外部ツールと拡張機能の活用

AUTOMATIC1111やComfyUIなどのインターフェース内のインペインティング機能を使用して、特定の領域の人体構造の誤りを手動で修正する 34。

ControlNetを深度マップ、OpenPoseなどと共に使用して、ポーズと人体構造に対するより強力な制御を行う 34。depth libraryのようなツールを使用すると、ControlNet内で深度マップを介して事前定義された手のポーズを使用できる 34。

Adetailer(After Detailer)を使用して、顔/手を自動検出し、それらの領域で特定のプロンプト/設定で拡散を再実行して、詳細を改善しエラーを修正する 20。LoRA生成後によく推奨される 20。

第6章:複雑な生成タスクにおけるLoRAと代替手法の比較

6.1 比較分析:Dreambooth、Textual Inversion、フルファインチューニング

- LoRA: パラメータ効率が高く、ファイルサイズが小さい(MB単位)、トレーニングが速い、凍結されたモデルに低ランク更新を追加する、バランスが良い 3。特定のレイヤー(例:アテンション 25)をターゲットにできる。

- Dreambooth: 特定の被写体に対してモデルのより多くの部分を微調整し、潜在的により高い忠実度/一貫性を実現するが、ファイルサイズが大きい(GB単位)、トレーニングが遅い、過学習/言語ドリフトしやすい 15。効率のためにLoRAと組み合わされることが多い 49。

- Textual Inversion: 新しいトークン埋め込みを学習し、ファイルサイズが非常に小さい(KB単位)、柔軟だが、特に複雑なスタイル/人体構造に対してはDreambooth/LoRAよりも潜在的に効力が低い/精度が低い 15。概念には適しているが、フォトリアリズムにはあまり適していない 53。

- フルファインチューニング: すべてのモデルの重みをトレーニングし、適応と品質の可能性が最も高いが、計算コストが非常に高く、大規模なデータセットが必要で、壊滅的な忘却のリスクが最も高い 14。LoRAはこのベースラインと比較されることが多い 14。

6.2 人体構造の忠実度のためのトレードオフ評価

人体構造に関して、Dreambooth/フルファインチューニングは、より多くのパラメータを変更するため、理論的には複雑な人体構造を学習する可能性が最も高いが、問題なく正しくトレーニングするのがより困難である(過学習 15)。LoRAは良好なバランスを提供するが、その限られたパラメータは非常に複雑な解剖学的適応に苦労する可能性がある。Textual Inversionは、一般的に正確な解剖学的制御には最も弱いと考えられている 53。

LoRAは一般的にDreambooth/フルFTよりもトレーニングが簡単/高速である 18。Textual Inversionも比較的速いが、高い忠実度を達成するのは難しい場合がある。Textual Inversionエンベディングは簡単に交換可能である 52。LoRAはポータブルである 18。Dreamboothモデルは大きなチェックポイントである。

単一の「最良の」方法はない。選択は特定の目標とリソースに依存する。特定の被写体に対する最大限の潜在的な解剖学的精度のためには、Dreamboothまたは(リソースが許せば)フルFTが、専門的にトレーニングされれば優れている可能性がある。しかし、LoRAは、慎重なデータセットキュレーションとパラメータ調整により「良好な」解剖学的結果を達成できる、はるかに実用的でリソース効率の高いアプローチを提供し、ほとんどのユーザーにとって好ましい方法となっている 18。メソッドの組み合わせ(例:Dreamboothモデル上のLoRA、またはネガティブプロンプト用のLoRA + Textual Inversion)は、それぞれの強みを活用できる。構図の難しさは、ユーザーを、その欠点にもかかわらず、より多くの訓練可能なパラメータを持つメソッド(Dreambooth/フルFT)に向かわせるか、あるいは強力な推論時制御(ControlNet、Adetailer)と組み合わせた綿密なLoRAトレーニングに向かわせる可能性がある。ユーザーは良好な人体構造を複雑なシーンで必要としている。異なるファインチューニングメソッドはベースモデルを異なる方法で変更する(LoRA=小さな更新、DB=大きな更新、TI=トークン、Full=全重み)。より多くの変更されたパラメータ(DB/Full)は、より複雑な解剖学的詳細の学習を可能にする「可能性がある」。しかし、より多くのパラメータは、より高いトレーニング難易度、コスト、および過学習リスクも意味する 15。LoRAはバランスを提供する:より簡単/安価だが、極端な解剖学的変更のための容量が潜在的に少ない 18。TIは一般的に正確な人体構造には最も適していない 53。したがって、最適なメソッドは、解剖学的複雑性の「程度」対利用可能なリソース/専門知識に依存する。多くの場合、適切に実行されたLoRA + 推論ツールで十分であり、最も実用的である。極端なケースでは、専門家レベルのDreambooth/フルFTが必要になるか、現在の技術にはまだ限界があることを認識する必要があるかもしれない 15。

表2:複雑な構図における人体構造安定性のためのファインチューニング手法の比較

| 手法 | 主要メカニズム | 標準ファイルサイズ | トレーニングリソース/時間 | 人体構造忠実度の可能性 | 主要な強み | 主要な弱点/リスク (人体構造/複雑性関連) | 関連出典 |

| LoRA | 事前学習済みモデルの一部(主にアテンション層)に低ランク行列を追加・学習 25 | MB単位 | 低/中 | 良好 | バランスが良い、高速、軽量、資源効率が高い 18 | 非常に複雑な構造/変形に対する適応能力に限界がある可能性。パラメータ調整が重要。 | 3 |

| Dreambooth | 特定の被写体についてモデルのより広範な部分をファインチューニング 49 | GB単位 | 高 | 高い | 特定被写体への高い忠実度・一貫性 15 | 過学習しやすい 50、言語ドリフト、トレーニングが難しい、ファイルサイズが大きい。 | 15 |

| Textual Inversion | 特定の概念を表す新しいトークン埋め込みを学習 51 | KB単位 | 低 | 限定的 | 非常に軽量、柔軟、概念学習に適している 52 | 正確な人体構造や複雑なスタイルの再現能力が低い傾向 53。 | 15 |

| フルファインチューニング | モデルの全パラメータをトレーニング | GB単位 | 非常に高い | 非常に高い(理論上) | 最大限の適応可能性 | 非常に高コスト、大規模データセットが必要、壊滅的な忘却のリスクが最大、トレーニングが極めて困難。 | 14 |

第7章:コミュニティの知恵:実践的な解決策と経験

7.1 フォーラムとプラットフォーム(Reddit、Civitai)からのアドバイスの統合

データセット/キャプションに関しては、手動キャプション、多様なデータセット(クローズアップ/全身の混合)、トリガーワードの使用、問題のあるソース画像(奇妙な表情、悪い照明)の回避がコミュニティで強く強調されている 20。具体的なキャプションの形式/例も共有されている 20。前処理にTopaz Gigapixelのようなツールを使用することも言及されている 20。

トレーニングに関しては、コミュニティ推奨の設定(特定のオプティマイザ 1、リアルな人物にはRealistic Vision 21、互換性のためにベースSD1.5 9)が共有されている。複数エポックのトレーニングと中間セーブのテストといった一般的な実践も言及されている 3。

推論に関しては、ネガティブエンベディング(EasyNegative, bad_prompt, negative_hand)の一般的な使用 35、LoRAウェイト調整 29、およびAdetailer 20 やControlNet/Depth Library 45 のようなツールの使用が強調されている。

プラットフォームとしては、Civitai 20 およびHugging Face 25 が、LoRA、モデル、ガイドを見つけるための主要なリソースとして挙げられている。コミュニティの議論はしばしばReddit(r/StableDiffusion、r/ComfyUI、r/civitai)で行われる 19。プラットフォームに関する潜在的な問題(例:Civitaiのパフォーマンス/モデレーション 56)にも注意が必要である。

7.2 一般的な落とし穴とユーザー発見の回避策

落とし穴としては、自動タグ付けへの過度の依存 20、意図した用途に対するデータセットの多様性不足、LoRAの「焼き付き」 3、ウェイト調整なしでの競合するLoRAの使用 29、不適切なベースモデルの選択 21 が挙げられる。

回避策としては、綿密な手動タグ付け 20、戦略的なデータセット拡張(アップスケーリング 20)、エポック/ステップの慎重なテスト 3、微調整のためのLoRAブロックウェイトの使用 1、ネガティブLoRAウェイト 1、LoRAの戦略的な組み合わせ 42、最終的な修正レイヤーとしての推論ツールの使用(Adetailer、ControlNet 20)がある。

第8章:結論と戦略的推奨事項

8.1 調査結果の統合的要約

複雑な構図のためのLoRAトレーニングにおける人体破綻は、多面的な性質を持つ問題である。主要な寄与要因として、過学習、データセットの限界(品質、多様性、タグ付け)、パラメータの不安定性、ベースモデルの弱点、そして複雑さ固有の課題が挙げられる。軽減策(推論時)だけに頼るよりも、予防(データセット、パラメータ)の方が効果的である。

8.2 状況に応じた推奨事項(実践的ワークフロー)

- 診断を優先: 問題が発生した場合、過学習(損失曲線、出力のばらつき)、データセットの欠陥(画像/タグのレビュー)、パラメータの競合を体系的に確認する。

- データセットを最優先: 高品質で多様なデータセットのキュレーションに多大な労力を投資する(第2章のガイドライン参照)。トリガー概念と可変タグを分離し、キャプションを手動で綿密に修正する。適切な解像度と焦点を確保する。

- 戦略的パラメータ調整: ベースモデル(SD1.5/SDXL/Flux)に推奨される設定から始める。LR、ランク、アルファ、ステップ数を反復的に調整する。「Nエポック/ステップごとに保存」を使用し、中間LoRAをテストする。高ランク/複雑性で不安定性に直面した場合は、rsLoRAや異なるオプティマイザを検討する。提案されたパラメータ調整表(第3章)を参照する。

- ベースモデルの選択: 意図するスタイル/被写体と互換性があり、合理的な人体構造安定性で知られるベースモデルを選択する(第4章参照)。必要に応じて、より広範な互換性のために基盤モデル(SD1.5/SDXL base)でトレーニングする。

- 推論時の改善: ネガティブプロンプト/エンベディングを賢明に使用する。特に複数のLoRAを組み合わせる場合は、LoRAウェイトを慎重に調整する。必要に応じて、AdetailerやControlNet(深度/ポーズ付き)のようなツールを最終的な修正に使用する(第5章参照)。

- 代替案の検討(必要な場合): 最善の努力にもかかわらず、LoRAが極度の複雑さに対して一貫して失敗する場合は、より高いリソース/スキル要件を認識した上でDreamboothを評価する(第6章参照)。

8.3 今後の展望:新たな技術

VeRA 17 やLoRAM 59 のような、より効率的で潜在的に安定したファインチューニングのための継続的な研究の可能性に言及する。これらは将来、複雑なタスクに対するより良い解決策を提供する可能性がある。ベースモデル(SD3、Flux 16)やコミュニティツールにおける継続的な開発が、人体構造レンダリングを改善し続けていることにも触れる。

引用文献

- LoRAを作りたかった|sylms – note, 4月 16, 2025にアクセス、 https://note.com/sylms/n/n8067f2d4c586

- LoRAとは:画像生成AI(Stable Diffusion)でイラスト作成に活用する方法も解説 – AI Front Trend, 4月 16, 2025にアクセス、 https://ai-front-trend.jp/lora/

- How to train Lora models – Stable Diffusion Art, 4月 16, 2025にアクセス、 https://stable-diffusion-art.com/train-lora/

- 半年くらいAIイラスト作りからLORA学習を学習して思った事|少年あべし – note, 4月 16, 2025にアクセス、 https://note.com/takoyudehidebu/n/n08060e146ba2

- How To Create Dataset For Training | SeaArt Guide, 4月 16, 2025にアクセス、 https://docs.seaart.ai/guide-1/3-advanced-guide/3-2-lora-training-advance/how-to-create-dataset-for-training

- LoRA Hyperparameters Guide – Unsloth Documentation, 4月 16, 2025にアクセス、 https://docs.unsloth.ai/get-started/beginner-start-here/lora-hyperparameters-guide

- LoRA学習のはじめ方 大規模モデルを効率的に微調整する手法 – AI導入.com, 4月 16, 2025にアクセス、 https://www.ai-dounyu.com/articles/how-lora-learning

- Training LoRA on Flux: Best Practices & Settings – finetuners.ai, 4月 16, 2025にアクセス、 https://www.finetuners.ai/post/training-lora-on-flux-best-practices-settings

- LoRA Training (Stable Diffusion 1.5) | ScottBaker.ca, 4月 16, 2025にアクセス、 https://www.scottbaker.ca/AI/LoRA-Training

- Step-by-Step SD Lora Training Guide with Kohya-SS – MimicPC, 4月 16, 2025にアクセス、 https://www.mimicpc.com/learn/sd-lora-training-guide-kohya-ss

- Finding the best LoRA parameters | Determined AI, 4月 16, 2025にアクセス、 https://www.determined.ai/blog/lora-parameters

- 実写系LoRA制作のポイント(2) | 株式会社フィジカルアイ, 4月 16, 2025にアクセス、 https://physical-i.jp/ai/realistic_lora_20240404/

- LoRAとは?メリットなどをわかりやすく解説 – IT用語一覧 – WebCli, 4月 16, 2025にアクセス、 https://it.webcli.jp/topics/lora/

- Fine-Tuning LLMs: LoRA or Full-Parameter? An in-depth Analysis with Llama 2 – Anyscale, 4月 16, 2025にアクセス、 https://www.anyscale.com/blog/fine-tuning-llms-lora-or-full-parameter-an-in-depth-analysis-with-llama-2

- The Comparison of the Effectiveness and Efficiency of Fine-Tuning Models on Stable Diffusion in Creating Concept Art – ResearchGate, 4月 16, 2025にアクセス、 https://www.researchgate.net/publication/380741801_The_Comparison_of_the_Effectiveness_and_Efficiency_of_Fine-Tuning_Models_on_Stable_Diffusion_in_Creating_Concept_Art

- Stable Diffusion 3.5 (Large): What You Need to Know – sandner.art, 4月 16, 2025にアクセス、 https://sandner.art/stable-diffusion-35-large-what-you-need-to-know/

- arxiv.org, 4月 16, 2025にアクセス、 https://arxiv.org/pdf/2310.11454

- Understanding LoRA’s Efficiency in Stable Diffusion Fine-Tuning – Spheron’s Blog, 4月 16, 2025にアクセス、 https://blog.spheron.network/understanding-loras-efficiency-in-stable-diffusion-fine-tuning

- Training a Stable Cascade LoRA is easy! : r/StableDiffusion – Reddit, 4月 16, 2025にアクセス、 https://www.reddit.com/r/StableDiffusion/comments/1diu92s/training_a_stable_cascade_lora_is_easy/

- Civitai character lora training : r/StableDiffusion – Reddit, 4月 16, 2025にアクセス、 https://www.reddit.com/r/StableDiffusion/comments/1iir1md/civitai_character_lora_training/

- After training 50+ LoRA Models here is what I learned (TIPS) : r …, 4月 16, 2025にアクセス、 https://www.reddit.com/r/StableDiffusion/comments/13dh7ql/after_training_50_lora_models_here_is_what_i/

- データセットの作成方法 – SeaArt Guide, 4月 16, 2025にアクセス、 https://docs.seaart.ai/guide-1/ri-ben-yu/3-nagaido/3-2-loratorningu/dtasettono

- プロンプトは考えたくないけど画像生成がしたい! – Zenn, 4月 16, 2025にアクセス、 https://zenn.dev/platina/articles/ea6a60f0ad69d0

- LoRAの限界を突破するLoRA+の画期的な学習率設定法 #AI – Qiita, 4月 16, 2025にアクセス、 https://qiita.com/kernelian/items/9897d6d45203c9139939

- Low-Rank Adaptation of Large Language Models (LoRA) – Hugging Face, 4月 16, 2025にアクセス、 https://huggingface.co/docs/diffusers/v0.19.3/training/lora

- Stable Diffusion 3.5 Large/Large Turbo/Mediumの使用経験|Browncat – note, 4月 16, 2025にアクセス、 https://note.com/browncatro1/n/n60aca3ed63de

- sazyou-roukaku/BracingEvoMix – Hugging Face, 4月 16, 2025にアクセス、 https://huggingface.co/sazyou-roukaku/BracingEvoMix

- 【論文瞬読】拡散モデルで3D人体復元の精度を向上!最新研究ScoreHMRの詳細解説|AI Nest, 4月 16, 2025にアクセス、 https://note.com/ainest/n/na39713b09924

- stable diffusion でLoRAを使用した時に画像が崩れる場合の対処法 – note, 4月 16, 2025にアクセス、 https://note.com/takuxan1142_/n/nc36f7523420a

- Lora models and how to use them with Stable Diffusion, 4月 16, 2025にアクセス、 https://learn.thinkdiffusion.com/how-to-use-loras/

- 【Stable Diffusion】おすすめのネガティブプロンプトまとめ! | PROMPTY – Taskhub, 4月 16, 2025にアクセス、 https://taskhub.jp/magazine/exercise/stable-diffusion/5335/

- Stable Diffusionのネガティブプロンプト利用法とその効果 | EdgeHUB – 株式会社ハイレゾ, 4月 16, 2025にアクセス、 https://highreso.jp/edgehub/stablediffusion/negativeprompt.html

- 【完全無料版】\脱初心者/Stable Diffusion プロンプトのコツ| はっかあめ – note, 4月 16, 2025にアクセス、 https://note.com/hakka_ame_/n/n7062a384edd5

- Stable Diffusionで手の指を修正するプロンプト呪文やDepth Libraryの使い方について解説, 4月 16, 2025にアクセス、 https://www.youtube.com/watch?v=MI34NK8gc00

- 【初心者向け】Stable Diffusion Embeddingの解説とEasyNegativeの使い方|Akuma公式 – note, 4月 16, 2025にアクセス、 https://note.com/akuma_ai/n/n20e5cfd09dd9

- Negative Embedding | UModeler X, 4月 16, 2025にアクセス、 https://docs.umodeler.com/docs/usage-guide/negative-embedding/

- 5 MUST Have Stable Diffusion Negative Embeddings – YouTube, 4月 16, 2025にアクセス、 https://www.youtube.com/watch?v=vhI3U8OZnc8

- New Negative Embedding ~ negative_hand : r/StableDiffusion – Reddit, 4月 16, 2025にアクセス、 https://www.reddit.com/r/StableDiffusion/comments/1364dsq/new_negative_embedding_negative_hand/

- Negative Embedding (Textual Inversion) for SD1.5 models | AI Illustration Blog DCAI, 4月 16, 2025にアクセス、 https://www.digitalcreativeai.net/en/post/recommended-negative-embedding-for-sd15-models

- This concept is not new. Lots of “negative embeddings” that you put into negativ… | Hacker News, 4月 16, 2025にアクセス、 https://news.ycombinator.com/item?id=37212338

- I created a negative embedding (Textual Inversion) : r/StableDiffusion – Reddit, 4月 16, 2025にアクセス、 https://www.reddit.com/r/StableDiffusion/comments/yy2i5a/i_created_a_negative_embedding_textual_inversion/

- Repository for the Paper “Multi-LoRA Composition for Image Generation” – GitHub, 4月 16, 2025にアクセス、 https://github.com/maszhongming/Multi-LoRA-Composition

- Stable Diffusionにおけるネガティブプロンプトの活用法:理想の画像を生成する秘訣 – note, 4月 16, 2025にアクセス、 https://note.com/kaokky42/n/n8f8f7c34585a

- MGHanD: Multi-modal Guidance for authentic Hand Diffusion – arXiv, 4月 16, 2025にアクセス、 https://arxiv.org/html/2503.08133v1

- 手の修正【HowTo】|BD – note, 4月 16, 2025にアクセス、 https://note.com/br_d/n/ne280118ffcae

- Efficient Multi-task LLM Quantization and Serving for Multiple LoRA Adapters – NIPS papers, 4月 16, 2025にアクセス、 https://proceedings.neurips.cc/paper_files/paper/2024/file/747dc7c6566c74eb9a663bcd8d057c78-Paper-Conference.pdf

- Stable Diffusionで手や指を崩さずに出力する方法修正する拡張機能もご紹介 – 株式会社Bocek, 4月 16, 2025にアクセス、 https://bocek.co.jp/media/exercise/stable-diffusion/5087/

- 「Stable Diffusionで手や指がおかしくなってしまう」を修正する方法 – depth libraryの使い方について – YouTube, 4月 16, 2025にアクセス、 https://m.youtube.com/watch?v=XzLue1pTsqs&pp=ygUOI2RlcHRoX2xpYnJhcnk%3D

- Fine-tuning Stable Diffusion XL with LoRA – AI Development Services, 4月 16, 2025にアクセス、 https://www.spaceo.ai/case-study/fine-tuning-stable-diffusion-xl/

- Low-Rank Adaptation of Large Language Models (LoRA) – Hugging Face, 4月 16, 2025にアクセス、 https://huggingface.co/docs/diffusers/v0.18.0/training/lora

- DreamBooth: Fine Tuning Text-to-Image Diffusion Models for Subject-Driven Generation | Request PDF – ResearchGate, 4月 16, 2025にアクセス、 https://www.researchgate.net/publication/373308424_DreamBooth_Fine_Tuning_Text-to-Image_Diffusion_Models_for_Subject-Driven_Generation

- LoRA vs Dreambooth vs Textual Inversion vs Hypernetworks – YouTube, 4月 16, 2025にアクセス、 https://www.youtube.com/watch?v=dVjMiJsuR5o

- Which fine tuning mechanism provides the best true to life realistic images of people? Dreambooth, textual inversion, hypernetworks, LoRA, aesthetic gradients or other? : r/StableDiffusion – Reddit, 4月 16, 2025にアクセス、 https://www.reddit.com/r/StableDiffusion/comments/11n1jbq/which_fine_tuning_mechanism_provides_the_best/

- Not All LoRA Parameters Are Essential: Insights on Inference Necessity – arXiv, 4月 16, 2025にアクセス、 https://arxiv.org/html/2503.23360v1

- Is there a guide on how to make effective LORAs using Civitai? : r/StableDiffusion – Reddit, 4月 16, 2025にアクセス、 https://www.reddit.com/r/StableDiffusion/comments/1e96cej/is_there_a_guide_on_how_to_make_effective_loras/

- Issue with Custom trained Lora – civitai – Reddit, 4月 16, 2025にアクセス、 https://www.reddit.com/r/civitai/comments/1ibw4eu/issue_with_custom_trained_lora/

- civitai – Reddit, 4月 16, 2025にアクセス、 https://www.reddit.com/r/civitai

- LoRA in negative prompt? : r/comfyui – Reddit, 4月 16, 2025にアクセス、 https://www.reddit.com/r/comfyui/comments/17fgxhr/lora_in_negative_prompt/

- Train Small, Infer Large: Memory-Efficient LoRA Training for Large Language Models, 4月 16, 2025にアクセス、 https://openreview.net/forum?id=s7DkcgpRxL